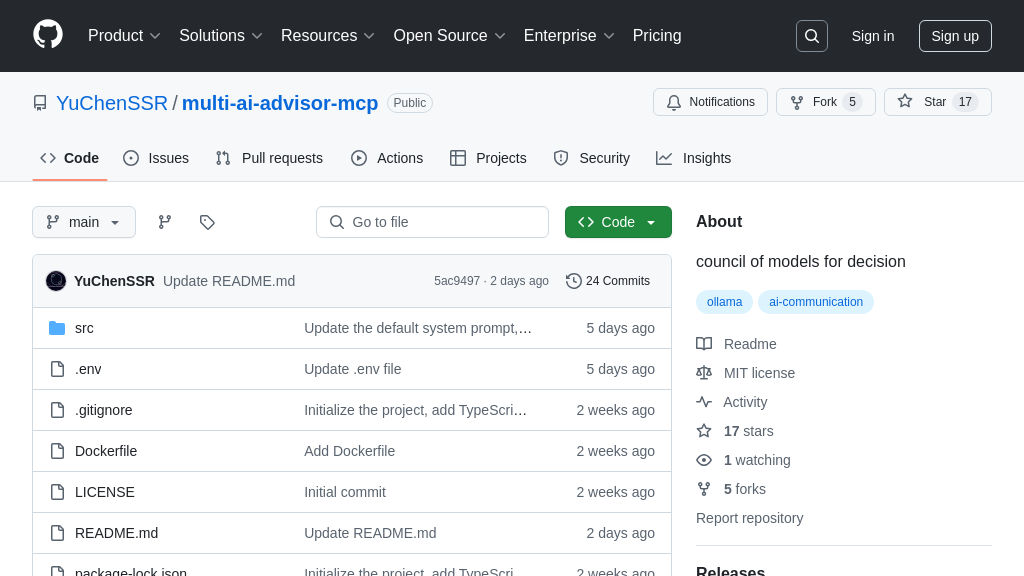

multi-ai-advisor-mcp

Multi-AI-Advisor-MCP:集成多Ollama模型,提供多样AI视角,打造你的专属AI顾问委员会。

multi-ai-advisor-mcp 解决方案概述

Multi-Model Advisor (锵锵四人行) 是一款MCP服务器,旨在为AI模型提供更全面的视角。它通过查询多个Ollama模型,并整合它们的响应,模拟一个“顾问委员会”,为单个问题提供多样化的人工智能观点。该服务器允许开发者为每个模型分配不同的角色和系统提示,从而定制它们的专业领域。

Multi-Model Advisor的核心价值在于帮助AI模型,特别是Claude,综合多个AI的观点,从而做出更明智的决策。它通过标准输入/输出与AI模型无缝集成,并支持HTTP/SSE等传输机制。开发者可以通过Smithery自动安装,或手动配置,轻松将其集成到Claude for Desktop中。通过利用多个模型的优势,Multi-Model Advisor显著提升了AI模型的推理和决策能力。

multi-ai-advisor-mcp 核心能力

多模型协同查询

Multi-AI-Advisor-MCP 的核心功能在于能够同时利用多个 Ollama 模型来响应用户的单个查询。它通过将用户的问题发送到预先配置的多个模型实例来实现这一点,每个模型都运行在 Ollama 平台上。服务器接收来自这些模型的响应,并将它们传递给客户端(例如 Claude),客户端可以综合这些不同的视角,从而为用户提供更全面的答案。这种方法模拟了一个“顾问委员会”,其中不同的 AI 模型扮演不同的角色,提供各自独特的见解。

例如,用户可以向 Claude 提出一个问题,并指定使用 gemma3:1b、llama3.2:1b 和 deepseek-r1:1.5b 这三个模型。Multi-AI-Advisor-MCP 会将问题发送到这三个模型,每个模型根据其自身的训练数据和系统提示生成答案。Claude 接收到这些答案后,可以综合它们,形成一个更全面、更具洞察力的回复。

从技术实现角度来看,该功能依赖于 Node.js 环境,并利用 query-models 工具与 Ollama 模型进行交互。每个模型都可以通过环境变量配置不同的系统提示,从而进一步定制其角色和视角。

模型角色自定义

该MCP解决方案允许为每个参与查询的Ollama模型分配不同的角色或系统提示。通过在.env文件中配置GEMMA_SYSTEM_PROMPT、LLAMA_SYSTEM_PROMPT和DEEPSEEK_SYSTEM_PROMPT等环境变量,开发者可以定义每个模型在回答问题时应扮演的角色。这种角色分配机制使得每个模型能够从独特的角度分析问题,从而丰富最终的综合答案。

例如,可以设置一个模型作为“创意助手”,另一个模型作为“逻辑分析师”,还有一个模型作为“情感支持者”。当用户提出一个需要多方面考虑的问题时,例如“如何平衡工作和生活?”,创意助手可以提供新颖的解决方案,逻辑分析师可以评估各种方案的优缺点,而情感支持者可以提供鼓励和建议。

在技术实现上,服务器在向每个Ollama模型发送查询时,会将相应的系统提示包含在请求中。Ollama模型会根据这些提示调整其回答风格和内容。这种机制为开发者提供了高度的灵活性,可以根据具体需求定制每个模型的行为。

动态模型发现与管理

Multi-AI-Advisor-MCP 允许用户查看系统上所有可用的 Ollama 模型,并动态地配置哪些模型参与到多模型查询中。通过 list-available-models 工具,用户可以获取已安装的 Ollama 模型列表,并了解哪些模型被设置为默认模型。这种动态发现和管理能力使得用户可以灵活地调整模型组合,以适应不同的查询需求和场景。

例如,如果用户想要了解某个特定领域的知识,他们可以首先使用 list-available-models 工具查看是否有相关的专业模型可用。如果找到了合适的模型,用户可以将其添加到默认模型列表中,或者在查询时显式地指定使用该模型。

在技术实现上,list-available-models 工具通过调用 Ollama API 获取模型列表,并将其格式化为易于理解的输出。用户可以通过修改配置文件或环境变量来更改默认模型列表。这种动态配置能力使得 Multi-AI-Advisor-MCP 可以适应不断变化的模型生态系统,并为用户提供最新的 AI 解决方案。