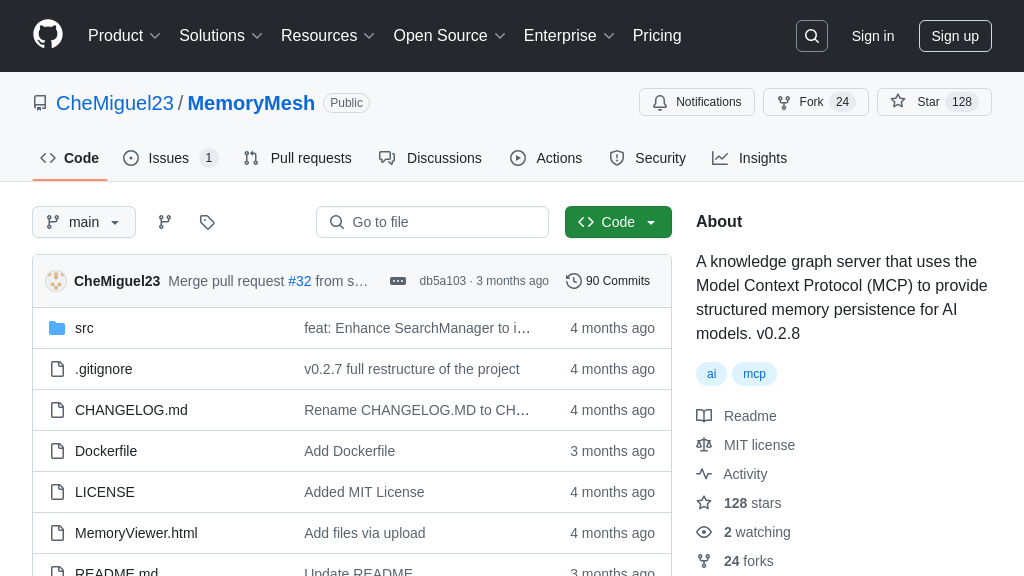

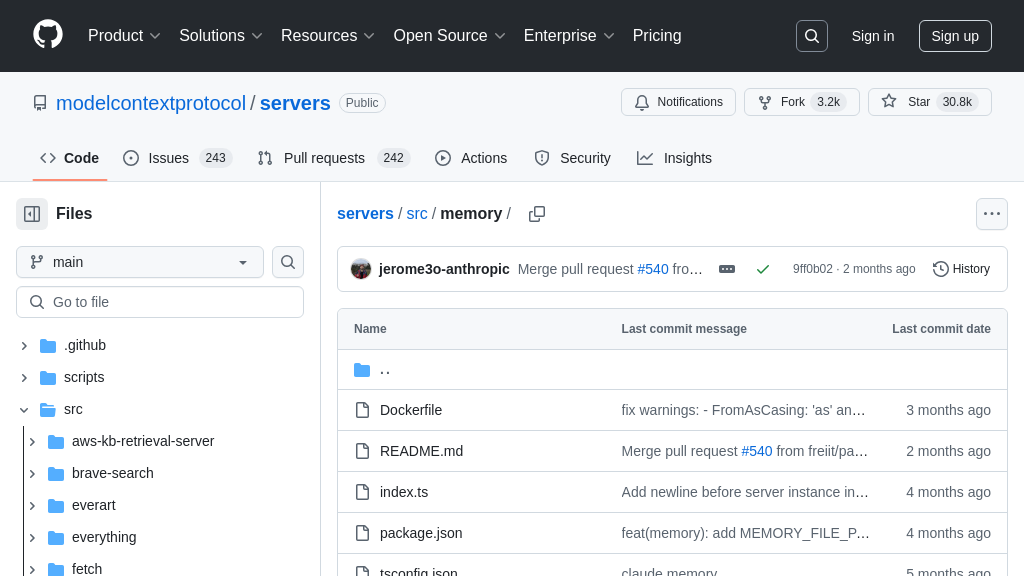

server-memory

server-memory:基于知识图谱的 MCP 服务器,为 AI 模型提供持久记忆。

server-memory 解决方案概述

server-memory 是一个基于本地知识图谱的持久化内存服务器,属于 MCP 生态系统的服务器组件。它旨在帮助 AI 模型,特别是像 Claude 这样的对话式 AI,记住关于用户的跨会话信息,从而实现更个性化的交互。

该服务器通过实体、关系和观察三个核心概念来构建知识图谱,并提供一系列 API 工具,如 create_entities、add_observations 和 search_nodes,用于管理和检索信息。开发者可以使用 Docker 或 NPX 快速部署 server-memory,并通过简单的 JSON 配置将其集成到 Claude Desktop 等应用中。

通过使用 server-memory,开发者可以显著提升 AI 模型的记忆能力,解决用户身份识别和信息持久化等痛点,从而构建更智能、更贴近用户需求的 AI 应用。该解决方案采用 MIT 许可证,允许自由使用、修改和分发。

server-memory 核心能力

持久化知识图谱存储

server-memory的核心功能是提供一个基于本地知识图谱的持久化存储方案,用于存储和检索AI模型与用户交互过程中产生的关键信息。它通过实体、关系和观察三种基本元素构建知识图谱,使AI模型能够记住用户的身份、偏好、行为和目标等信息,从而实现个性化和上下文相关的对话。该功能解决了AI模型在会话之间“失忆”的问题,使得AI能够像人类一样,基于历史记忆进行更自然和高效的交流。例如,Claude可以通过server-memory记住用户的姓名、工作单位和兴趣爱好,并在后续对话中直接引用这些信息,无需用户重复告知。

实体关系管理API

server-memory提供了一组完整的API,用于创建、读取、更新和删除知识图谱中的实体和关系。这些API包括create_entities、create_relations、add_observations、delete_entities、delete_observations、delete_relations、read_graph、search_nodes和open_nodes。开发者可以使用这些API轻松地管理知识图谱的内容,并根据需要检索相关信息。例如,当用户告知Claude一个新的兴趣爱好时,开发者可以使用add_observations API将该信息添加到用户对应的实体中。这些API简化了知识图谱的管理,降低了开发者使用知识图谱的门槛。

灵活的部署选项

server-memory提供了多种部署选项,包括Docker和NPX,方便开发者根据自己的需求选择合适的部署方式。使用Docker可以实现快速部署和隔离,而使用NPX则可以直接从npm仓库运行server-memory。此外,server-memory还支持通过环境变量进行配置,例如可以自定义知识图谱存储文件的路径。这种灵活性使得server-memory可以轻松地集成到各种不同的环境中。例如,开发者可以使用Docker将server-memory部署到云服务器上,或者使用NPX在本地开发环境中运行server-memory。

全文搜索与节点检索

server-memory 提供了强大的搜索功能,允许开发者通过关键词查询知识图谱中的实体。search_nodes API 可以在实体名称、类型和观察内容中进行全文搜索,快速定位到相关的实体。此外,open_nodes API 允许通过实体名称直接检索特定的节点及其关系。这些搜索功能极大地提高了信息检索的效率,使得 AI 模型能够快速找到所需的上下文信息。例如,当用户询问关于某个特定项目的信息时,Claude 可以使用 search_nodes API 搜索与该项目相关的实体,并检索出相关的观察和关系,从而为用户提供更准确的答案。