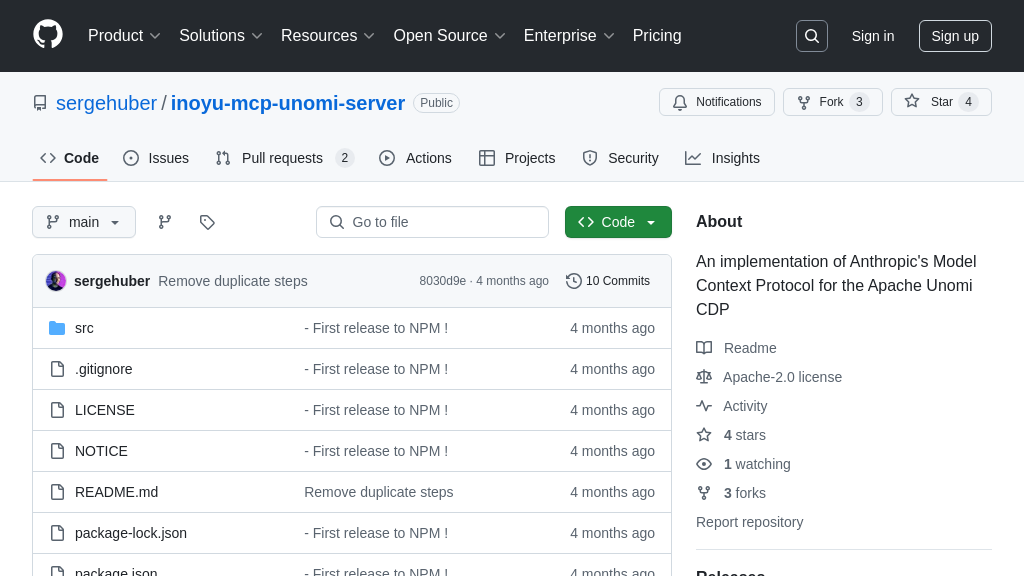

inoyu-mcp-unomi-server

Inoyu Apache Unomi MCP Server:为Claude提供用户上下文管理的MCP服务器。

inoyu-mcp-unomi-server 解决方案概述

Inoyu Apache Unomi MCP Server是一款服务器类型的MCP解决方案,旨在增强AI模型(特别是Anthropic的Claude)的用户上下文感知能力。它充当Claude与Apache Unomi(一款客户数据平台)之间的桥梁,使Claude能够通过Unomi的profile管理功能维护用户偏好和信息,从而实现跨会话的用户身份识别和一致的上下文管理。

该服务器提供诸如基于邮箱的用户profile查找和创建、profile属性管理、基础会话处理以及基于作用域的上下文隔离等关键功能。开发者可以通过简单的配置,将此服务器集成到Claude Desktop中,利用其提供的工具(如get_my_profile和update_my_profile)无缝地与Unomi交互,存储和检索用户数据。通过自动管理作用域,该服务器还简化了多应用或多上下文环境下的数据隔离。使用Inoyu Unomi MCP Server,开发者可以显著提升AI模型的用户体验,使其能够更好地理解和响应用户需求。

inoyu-mcp-unomi-server 核心能力

用户画像持久化

Inoyu-mcp-unomi-server 的核心功能是利用 Apache Unomi 平台为 AI 模型(如 Claude)提供用户画像持久化能力。它允许 AI 模型跨会话记住用户的偏好和信息,从而提供更个性化和一致的交互体验。该服务器通过 Unomi 的 profile 管理功能,将用户数据存储在 Unomi 中,并根据用户的 email 或 profile ID 进行检索。这意味着即使在不同的会话中,AI 模型也能识别出同一用户,并根据其历史数据进行响应。例如,用户在第一次对话中表达了对科幻电影的兴趣,下次对话时,AI 模型可以主动推荐相关的电影或书籍。

从技术实现角度看,该服务器通过 get_my_profile 工具获取用户画像,并使用 update_my_profile 工具更新用户属性。它还支持通过 UNOMI_EMAIL 环境变量进行 email 查找,从而实现更灵活的用户识别。

上下文管理与隔离

该服务器通过 scope 管理功能,实现了上下文管理和隔离。Scope 在 Unomi 中用于隔离不同应用或环境的数据,防止数据冲突和信息泄露。Inoyu-mcp-unomi-server 默认使用 claude-desktop scope,并支持通过 create_scope 工具创建自定义 scope。这意味着开发者可以为不同的 AI 应用创建独立的上下文,确保数据安全和隐私。例如,一个 AI 模型用于客户服务,另一个用于产品推荐,可以分别创建不同的 scope,避免客户服务数据影响产品推荐结果。

在技术实现上,服务器会自动检查所需 scope 是否存在,如果不存在则自动创建,并使用有意义的默认值设置 scope 元数据。这简化了配置过程,并确保了 scope 的正确使用。

简化集成与配置

Inoyu-mcp-unomi-server 旨在简化 AI 模型与 Apache Unomi 的集成和配置。它提供了一套易于使用的工具和配置选项,降低了开发者的学习成本和集成难度。通过 Claude Desktop 的配置文件,开发者可以轻松地配置 Unomi 服务器的连接信息,包括 URL、用户名、密码和 profile ID。服务器还提供了详细的文档和故障排除指南,帮助开发者解决常见问题。例如,开发者可以通过简单的配置,将 AI 模型连接到 Unomi 服务器,并使用 get_my_profile 和 update_my_profile 工具进行用户画像的管理。

从技术实现角度看,服务器使用环境变量进行配置,并提供了多种配置选项,包括指定版本和本地安装路径。它还提供了调试工具和日志,方便开发者进行问题排查。

技术实现

Inoyu-mcp-unomi-server 使用 Node.js 构建,并通过 npm 进行包管理。它提供了一套完整的开发流程,包括安装依赖、构建服务器和运行调试工具。服务器使用标准输入/输出 (stdio) 与 AI 模型进行通信,并支持 HTTP/SSE 等传输机制。为了方便调试,服务器还提供了 MCP Inspector 工具,可以通过浏览器访问调试界面。此外,服务器还提供了详细的日志记录,方便开发者进行问题排查。例如,开发者可以使用 npm run inspector 命令启动 MCP Inspector,并在浏览器中查看 AI 模型与服务器之间的通信数据。