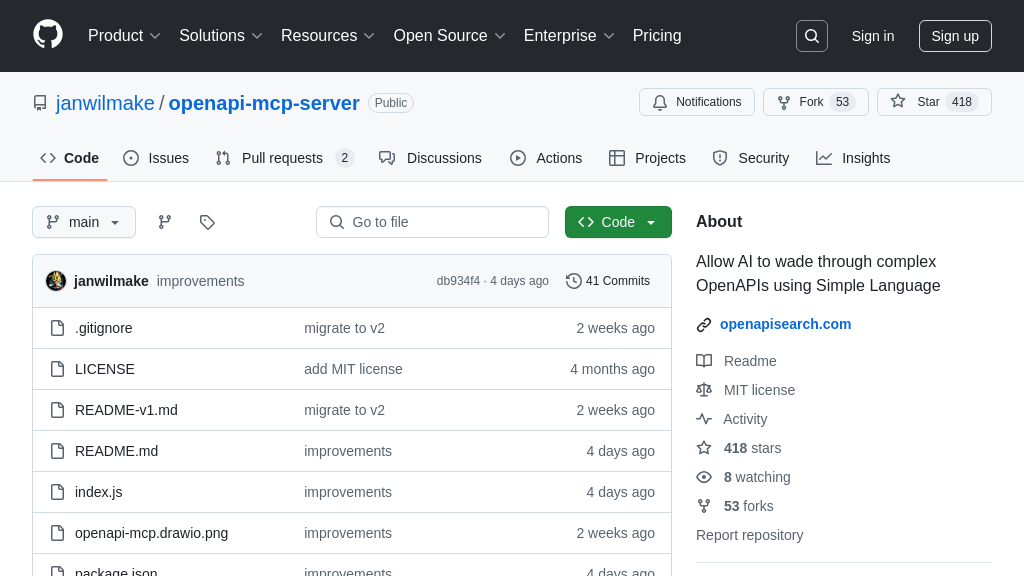

openapi-mcp-server

OpenAPI MCP Server: Connects AI models to OpenAPI specs for easy API exploration and integration.

openapi-mcp-server Solution Overview

OpenAPI MCP Server is an MCP server designed to empower AI models like Claude and Cursor with the ability to seamlessly search and explore OpenAPI specifications through oapis.org. It acts as a bridge, allowing AI to understand and interact with complex APIs using natural language.

This server enables AI to retrieve overviews of any OpenAPI specification and obtain detailed information about specific API operations, supporting both JSON and YAML formats. By integrating with MCP clients, it allows AI to first grasp the API's context and then delve into specific endpoints as needed.

The core value lies in simplifying API interaction for AI, making it easier to generate code, understand API functionality, and ultimately leverage external services more effectively. While direct endpoint execution isn't supported due to authentication limitations, its focus on API exploration and contextual understanding makes it ideal for code generation and API learning. To get started, simply run npx openapi-mcp-server@latest init.

openapi-mcp-server Key Capabilities

OpenAPI 规范快速概览

openapi-mcp-server 允许 AI 模型通过自然语言快速获取任何 OpenAPI 规范的概览。它通过 oapis.org 索引的 OpenAPI 规范,响应 AI 模型的查询,提供 API 的用途、主要功能和关键端点的摘要信息。这使得 AI 模型能够理解 API 的整体结构和功能,无需处理冗长的 YAML 或 JSON 文件。例如,AI 模型可以查询 "Stripe API 的作用是什么?",服务器会返回 Stripe API 的简要描述,包括其主要功能,如支付处理和订阅管理。这极大地提高了 AI 模型理解和利用 API 的效率,尤其是在处理大型或不熟悉的 API 时。技术上,服务器通过检索预先索引的 OpenAPI 规范元数据来实现这一点。

API 操作细节检索

该服务器能够检索关于特定 API 操作的详细信息,并以易于理解的格式呈现给 AI 模型。当 AI 模型需要了解特定端点的工作方式或参数时,它可以向服务器发送请求,例如 "解释 GitHub API 的存储库端点如何使用"。服务器会返回该端点的详细描述,包括其参数、请求体格式和可能的响应代码。这使得 AI 模型能够准确地理解如何使用 API 端点,从而避免错误并提高开发效率。此功能对于代码生成特别有用,因为 AI 模型可以根据检索到的信息生成正确的 API 调用代码。服务器通过解析 OpenAPI 规范并提取相关信息来实现这一点,然后将其转换为自然语言描述。

JSON/YAML 格式支持

openapi-mcp-server 支持处理 JSON 和 YAML 格式的 OpenAPI 规范。这意味着它可以与各种 API 提供商和工具链无缝集成,无论它们使用哪种格式来描述其 API。服务器能够自动检测和解析这两种格式,并以统一的方式向 AI 模型提供信息。例如,如果 AI 模型需要了解一个使用 YAML 格式定义的 API,它可以像查询 JSON 格式的 API 一样进行查询,服务器会自动处理格式转换。这种灵活性简化了 AI 模型与不同 API 之间的交互,并提高了其通用性。在技术层面,服务器使用相应的 JSON 和 YAML 解析库来处理不同格式的 OpenAPI 规范。

集成优势

openapi-mcp-server 的一个关键优势是其易于集成到现有的 MCP 生态系统中。它可以与任何 MCP 客户端(如 Claude Desktop 和 Cursor)无缝集成,允许 AI 模型通过标准化的 MCP 协议访问 OpenAPI 规范信息。这种集成简化了 AI 模型与 API 之间的交互,并提高了其可移植性。开发者可以轻松地将 openapi-mcp-server 添加到他们的 MCP 环境中,而无需进行大量的配置或代码修改。此外,由于 MCP 协议的标准化特性,AI 模型可以轻松地切换到不同的 API 服务器,而无需修改其查询逻辑。这为开发者提供了更大的灵活性和选择。