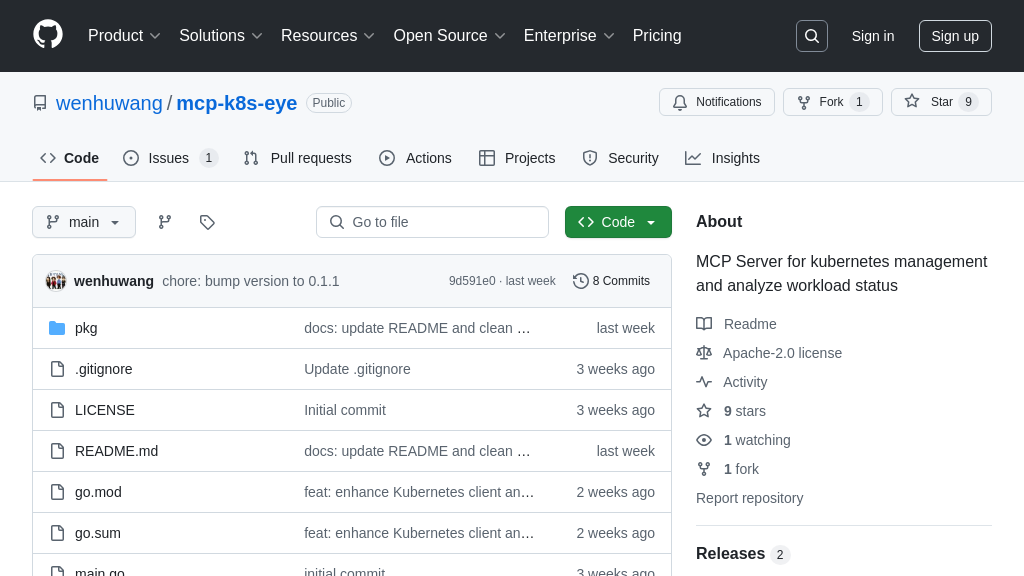

mcp-k8s-eye 解决方案概述

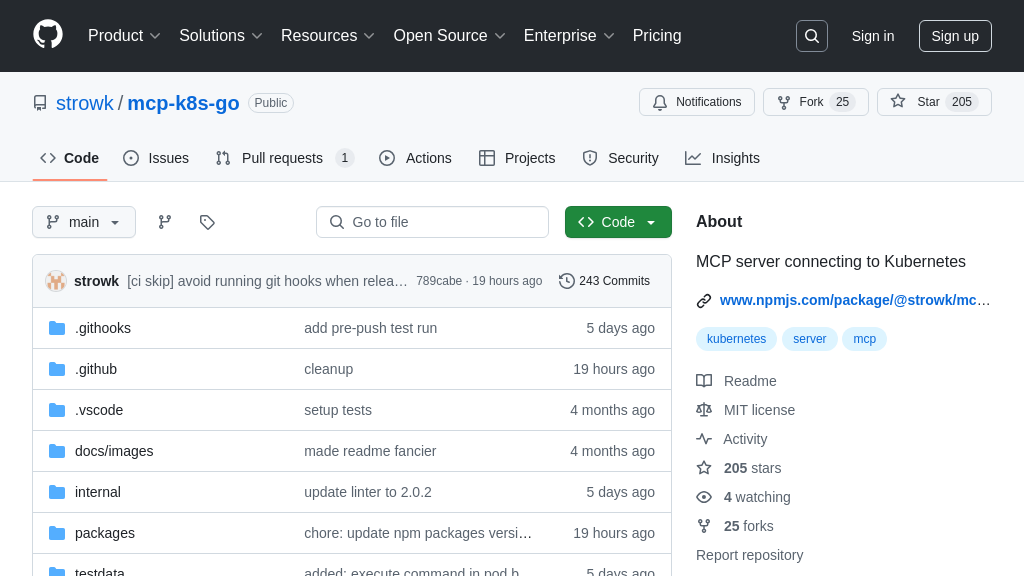

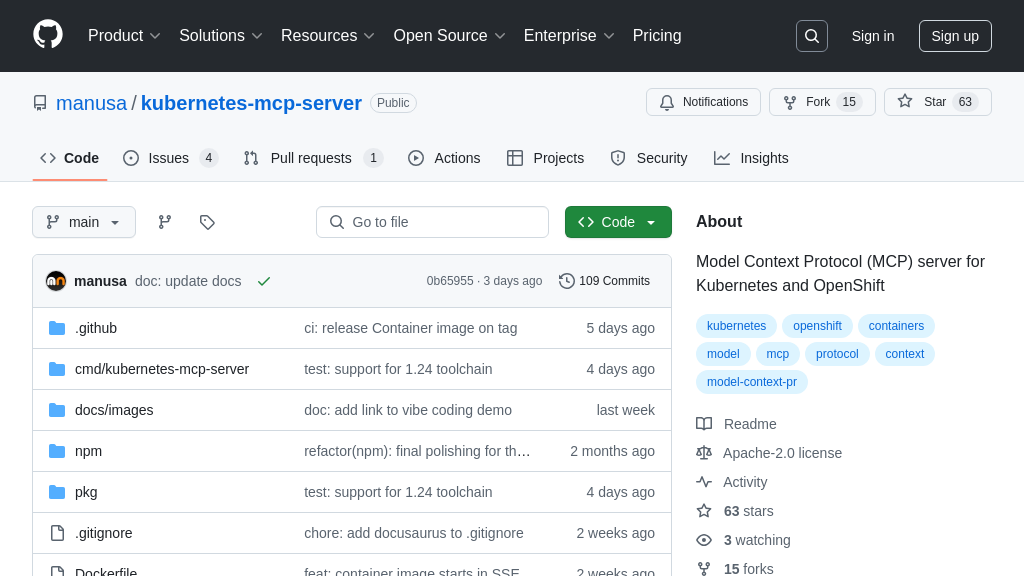

mcp-k8s-eye 是一款 MCP Server,专为 Kubernetes 集群的管理和工作负载状态分析而设计。它提供了一系列强大的功能,包括 Pod、Deployment、Service 等多种 Kubernetes 资源的管理,例如列表查看、详情获取、扩容、删除等操作。同时,它还能深入分析 Pods、Services 和 Deployments 等的工作状态,帮助开发者更好地理解和优化集群性能。

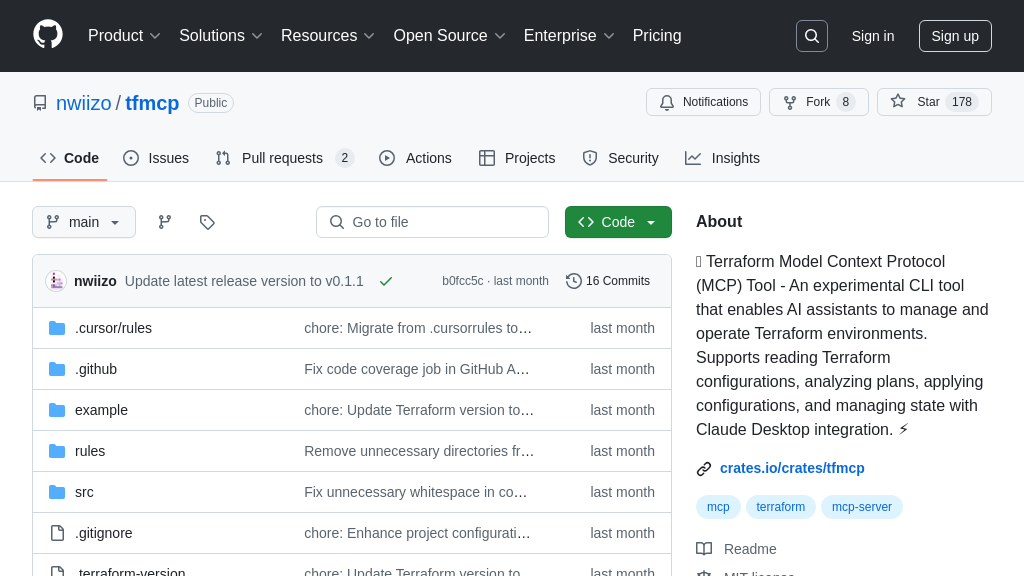

通过简单的配置,mcp-k8s-eye 能够与 AI 模型无缝集成,为 AI 应用提供可靠的 Kubernetes 集群管理能力。开发者可以通过标准 MCP 接口,轻松地从 AI 模型中调用 Kubernetes 集群的管理功能,极大地简化了 AI 应用的部署和运维流程。该工具使用 Go 语言开发,易于安装和部署,只需简单的配置即可接入 MCP 生态系统,显著提升 AI 模型在 Kubernetes 环境中的适应性和可管理性。

mcp-k8s-eye 核心能力

Kubernetes 集群统一管理

mcp-k8s-eye 作为一个 MCP Server,其核心功能在于提供对 Kubernetes 集群的统一管理能力。它允许用户通过标准化的 MCP 接口,执行常见的 Kubernetes 操作,例如列出、获取、删除 Pod、Deployment、Service 等资源。这极大地简化了 AI 模型与底层 Kubernetes 基础设施的交互,无需 AI 模型直接调用 Kubernetes API,降低了 AI 模型与基础设施的耦合度。例如,一个 AI 模型需要动态调整其部署的资源配额,可以通过 MCP 客户端向 mcp-k8s-eye 发送请求,后者负责与 Kubernetes 集群交互,完成资源调整。这种方式提高了 AI 模型的可移植性和可维护性。技术实现上,mcp-k8s-eye 使用 Go 语言开发,并依赖 kubectl 命令行工具与 Kubernetes 集群进行通信。

工作负载状态深度分析

除了基本的资源管理,mcp-k8s-eye 还具备对 Kubernetes 工作负载状态的深度分析能力。它可以分析 Pod、Service、Deployment 等资源的状态,并提供相关的指标和告警信息。这使得 AI 模型能够更好地了解其运行环境,并根据环境变化做出相应的调整。例如,mcp-k8s-eye 可以监控 Pod 的 CPU 和内存使用率,当某个 Pod 的资源使用率超过阈值时,它可以向 AI 模型发送告警,提示模型进行优化或扩容。这种主动式的监控和分析能力,有助于提高 AI 模型的稳定性和性能。技术实现上,mcp-k8s-eye 通过 Kubernetes API 获取资源状态信息,并使用内置的分析算法进行处理。

安全隔离与权限控制

mcp-k8s-eye 在 MCP 生态系统中扮演着安全网关的角色,它负责对来自 AI 模型的请求进行鉴权和授权,确保只有经过授权的 AI 模型才能访问 Kubernetes 集群。这有效地防止了未经授权的访问,提高了 Kubernetes 集群的安全性。例如,可以配置 mcp-k8s-eye,只允许特定的 AI 模型访问特定的 Kubernetes 命名空间,从而实现细粒度的权限控制。此外,mcp-k8s-eye 还可以记录所有来自 AI 模型的请求,方便进行审计和追踪。这种安全隔离和权限控制机制,为 AI 模型在 Kubernetes 集群中的安全运行提供了保障。技术实现上,mcp-k8s-eye 可以与现有的身份认证系统集成,例如 OAuth 2.0 和 OpenID Connect。

集成优势

mcp-k8s-eye 作为 MCP Server,能够无缝集成到 MCP 生态系统中。通过 MCP 协议,它可以与各种 MCP 客户端进行通信,例如 AI 模型、数据分析工具等。这种集成能力使得 AI 模型能够方便地访问 Kubernetes 集群,并利用 Kubernetes 的强大功能。此外,mcp-k8s-eye 还可以与其他 MCP Server 协同工作,例如数据存储服务、消息队列服务等,共同构建一个完整的 AI 解决方案。例如,一个 AI 模型可以使用 mcp-k8s-eye 管理其在 Kubernetes 集群中的部署,同时使用数据存储服务存储其训练数据和模型参数。这种集成优势,使得 MCP 生态系统能够提供更加灵活和强大的 AI 解决方案。