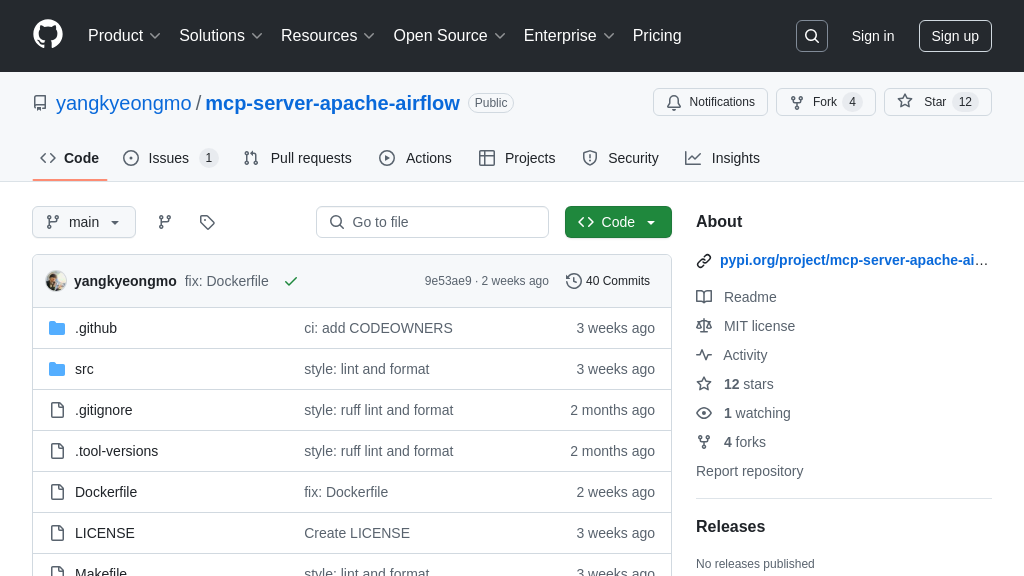

mcp-server-apache-airflow

mcp-server-apache-airflow:一个用于连接AI模型和Apache Airflow的MCP服务器,实现工作流自动化。

mcp-server-apache-airflow 解决方案概述

mcp-server-apache-airflow 是一款 MCP 服务器,旨在实现 AI 模型与 Apache Airflow 的无缝集成。它通过标准化的 MCP 协议,让 AI 客户端能够安全地与 Airflow 的 REST API 交互,从而简化了 AI 模型编排和数据管道管理。该服务器支持 DAG 管理、DAG 运行、任务管理、变量、连接等多种 Airflow 功能,并提供全面的 API 覆盖。开发者可以通过它,在 AI 模型中轻松触发、监控和管理 Airflow 工作流,极大地增强了 AI 模型的自动化能力和数据处理效率。通过使用官方 Apache Airflow 客户端库,保证了兼容性和可维护性。该解决方案通过标准输入/输出或 HTTP/SSE 等传输机制与 AI 模型通信,为 AI 应用集成 Airflow 提供了便捷途径。

mcp-server-apache-airflow 核心能力

Airflow DAG 管理

mcp-server-apache-airflow 允许通过 MCP 客户端对 Apache Airflow 的 DAG(有向无环图)进行全面的管理。这包括列出所有 DAG、获取特定 DAG 的详细信息、暂停和取消暂停 DAG、更新 DAG 定义以及删除 DAG。通过标准化的 MCP 协议,AI 模型可以安全地触发和监控 Airflow 工作流,而无需直接访问 Airflow 的内部 API。例如,一个 AI 模型可以根据数据质量检查的结果自动暂停一个 DAG,或者在完成模型训练后启动一个新的 DAG 运行。这种集成简化了 AI 模型与数据管道的交互,并促进了自动化工作流程的创建。该功能通过包装 Airflow 的 /api/v1/dags 端点实现,确保与 Airflow 版本的兼容性。

细粒度 DAG 运行控制

该服务器支持对 Airflow DAG 运行的精细控制,包括列出 DAG 运行、创建新的 DAG 运行、获取特定 DAG 运行的详细信息、更新 DAG 运行状态以及删除 DAG 运行。此外,还支持批量获取 DAG 运行信息、清除 DAG 运行以及设置 DAG 运行的注释。这种细粒度的控制能力使得 AI 模型能够精确地管理其依赖的 Airflow 工作流。例如,一个 AI 模型可以创建一个新的 DAG 运行来处理新收集的数据,或者在检测到错误时更新 DAG 运行的状态。通过 Airflow 的 /api/v1/dags/{dag_id}/dagRuns 端点实现,确保了与 Airflow 的无缝集成。

变量和连接管理

mcp-server-apache-airflow 提供了对 Airflow 变量和连接的管理功能。变量用于存储可以在 DAG 之间共享的配置信息,而连接则用于存储访问外部系统(如数据库或云存储)所需的凭据。通过 MCP 客户端,可以列出、创建、获取、更新和删除变量和连接。这使得 AI 模型能够动态地配置其运行环境,并安全地访问所需的数据源和服务。例如,一个 AI 模型可以根据当前的环境变量选择不同的模型参数,或者使用存储在 Airflow 连接中的凭据访问训练数据。该功能通过包装 Airflow 的 /api/v1/variables 和 /api/v1/connections 端点实现,提供了安全和标准化的访问方式。

技术实现:API 组选择

为了提高灵活性和安全性,mcp-server-apache-airflow 允许用户通过 --apis 标志选择要启用的 API 组。这使得用户可以根据其特定需求限制 MCP 客户端可以访问的 Airflow 功能,从而降低潜在的安全风险。例如,如果一个 AI 模型只需要管理 DAG 运行,则可以只启用 dagrun API 组,而禁用其他 API 组。这种选择性启用 API 组的功能增强了系统的安全性,并降低了攻击面。该功能通过在服务器启动时解析命令行参数来实现,并根据选择的 API 组动态地注册相应的路由。