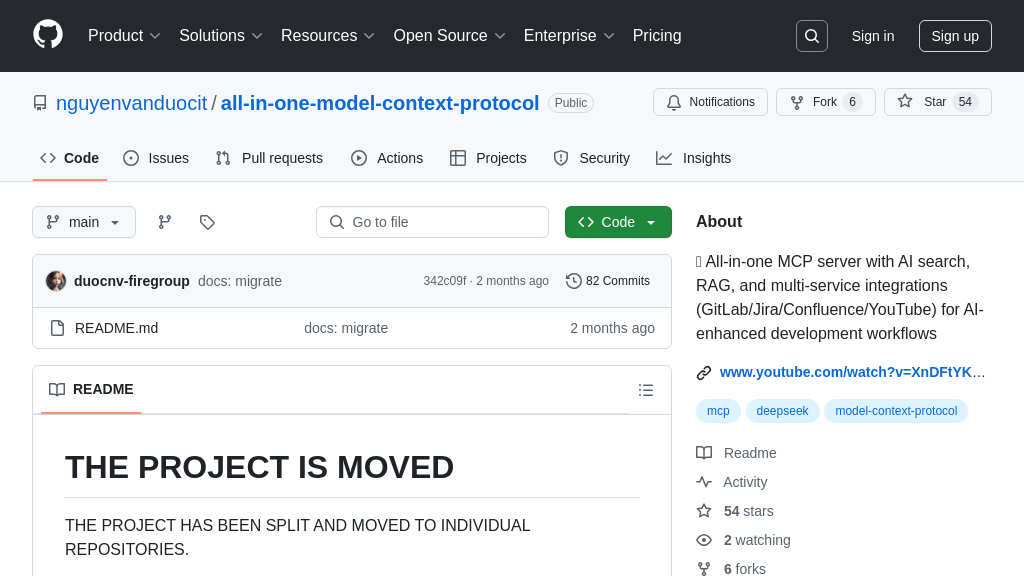

all-in-one-model-context-protocol

All-in-one MCP服务器,集成AI搜索、RAG和多服务,增强AI开发工作流程。

all-in-one-model-context-protocol 解决方案概述

all-in-one-model-context-protocol 是一个强大的MCP服务器解决方案,旨在通过集成包括GitLab、Jira、Confluence和YouTube在内的多种服务,增强AI模型在软件开发工作流程中的能力。它提供AI驱动的搜索功能,帮助开发者快速定位所需信息,并提供一系列实用工具,简化开发流程。

该服务器通过标准输入/输出或HTTP/SSE与AI模型无缝交互,使模型能够安全地访问和利用外部数据源和服务。核心价值在于其多服务集成能力,开发者无需手动切换和查询多个平台,即可在一个统一的界面中完成信息检索和任务执行。

通过Smithery或Go进行安装,开发者可以轻松部署此服务器,并通过简单的配置启用所需的工具集,例如Gemini搜索、RAG工具和Deepseek AI工具等。这使得AI模型能够更好地理解上下文,从而生成更准确、更有用的结果,显著提升开发效率和质量。

all-in-one-model-context-protocol 核心能力

AI驱动的统一搜索

all-in-one-model-context-protocol 的核心功能之一是其强大的AI驱动搜索能力。它集成了Gemini和Brave Search等多种搜索引擎,并能连接到GitLab、Jira和Confluence等多个服务,允许AI模型通过一个统一的接口访问和检索信息。这种集成避免了在不同平台间切换和手动搜索的麻烦,极大地提高了信息获取的效率。例如,开发者可以使用自然语言查询,快速找到与特定bug相关的Jira issue、相关的GitLab代码提交以及Confluence上的设计文档。技术实现上,该功能依赖于各个服务的API接口,并通过环境变量进行配置,保证了灵活性和可扩展性。

多服务集成与工作流增强

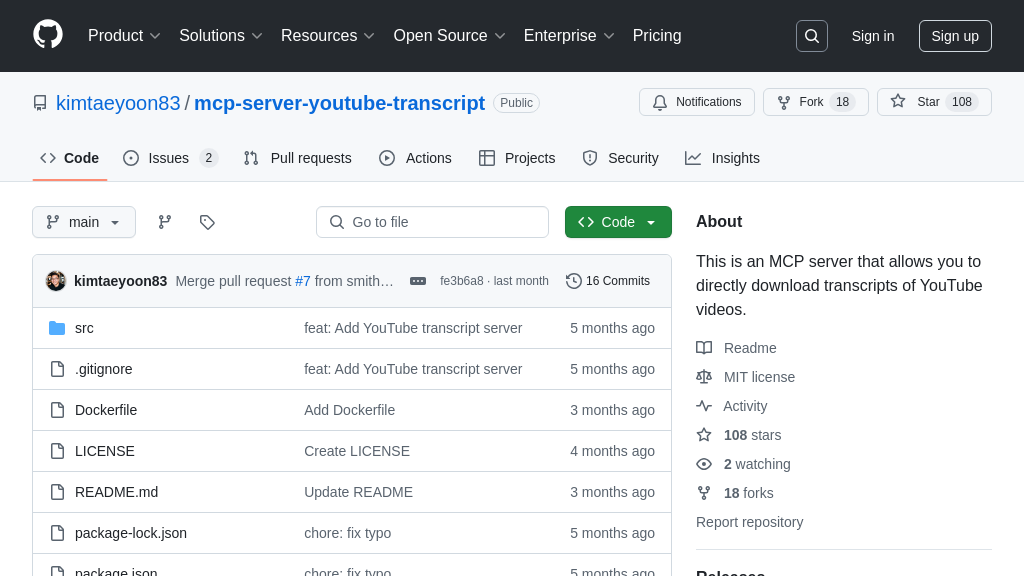

该MCP解决方案通过集成GitLab、Jira、Confluence和YouTube等常用开发工具,实现了AI增强的开发工作流程。这种集成使得AI模型能够直接访问和操作这些服务中的数据,从而实现自动化任务和智能辅助。例如,AI模型可以自动分析代码提交历史,识别潜在的bug,并在Jira中创建相应的issue;或者根据Confluence上的文档自动生成代码注释。这种集成简化了开发流程,减少了手动操作,提高了开发效率。技术实现上,每个服务的集成都通过特定的工具实现,例如gitlab_create_MR_note,并通过API密钥和Token进行身份验证。

RAG增强的知识检索

all-in-one-model-context-protocol 提供了基于RAG(Retrieval-Augmented Generation)的内存索引功能,允许AI模型快速检索和利用外部知识。通过RAG_memory_index_content和RAG_memory_index_file等工具,可以将文本内容和本地文件索引到内存中,并使用RAG_memory_search进行快速检索。这使得AI模型能够访问最新的文档、代码片段和其他相关信息,从而生成更准确、更相关的响应。例如,AI模型可以根据用户的问题,从索引的文档中检索相关信息,并结合自身知识生成答案。技术实现上,该功能依赖于向量数据库技术,例如Qdrant,并通过环境变量进行配置。

工具管理与动态配置

该MCP解决方案提供灵活的工具管理功能,允许用户根据需要启用或禁用特定的工具。通过tool_manager工具,可以动态地配置AI模型可以访问的工具,从而实现定制化的功能组合。例如,如果用户只需要使用GitLab和Jira的集成,可以禁用其他工具,从而减少资源消耗和提高安全性。这种灵活性使得该MCP解决方案能够适应不同的应用场景和用户需求。技术实现上,该功能通过环境变量ENABLE_TOOLS进行配置,允许用户指定需要启用的工具组。

安全沙箱脚本执行

all-in-one-model-context-protocol 包含一个安全沙箱脚本执行环境,允许AI模型执行命令行脚本,从而实现更复杂的操作。execute_comand_line_script 工具提供了沙箱执行、超时保护和输出捕获等安全特性,确保脚本执行不会对系统造成损害。例如,AI模型可以使用该工具自动部署代码、运行测试或执行其他系统管理任务。为了保证安全性,该工具限制了可执行的解释器列表,并对工作目录进行验证,防止未经授权的访问。