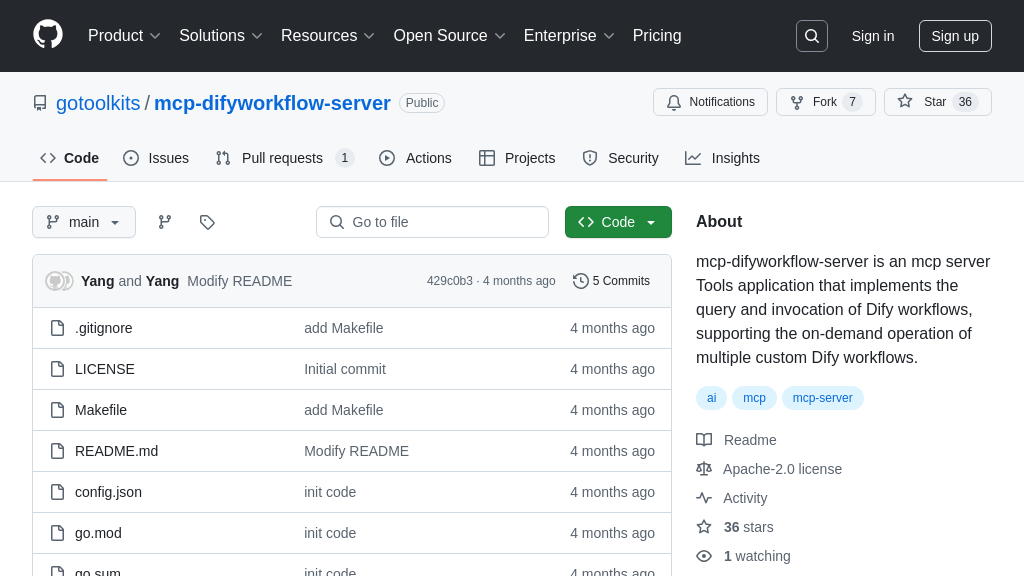

DifyWorkflow 解决方案概述

DifyWorkflow 是一个 MCP 服务器工具,专注于 Dify 工作流的查询与调用。它允许开发者通过 MCP 协议安全地与 Dify 工作流交互,从而将 AI 模型与预定义的 Dify 工作流无缝集成。通过简单的配置,即可列出可用的工作流并执行特定工作流,极大地扩展了 AI 模型的功能边界。

该工具的核心价值在于简化了 AI 模型与复杂工作流的集成过程,开发者无需深入了解底层实现,即可轻松调用 Dify 中预设的各种功能,例如翻译、图像生成等。DifyWorkflow 基于 Go 语言开发,通过标准输入/输出或 HTTP/SSE 等方式与 MCP 客户端通信,易于部署和集成到现有系统中。它解决了开发者在 AI 应用中集成复杂工作流的痛点,提升了开发效率和应用灵活性。

DifyWorkflow 核心能力

工作流查询与发现

DifyWorkflow 允许 AI 模型通过 MCP 协议动态查询和发现 Dify 平台上可用的工作流。该功能通过 list_workflows 命令实现,返回已授权给 MCP 服务器的工作流列表。这使得 AI 模型能够根据当前任务的需求,自主选择合适的工作流来执行,极大地提升了 AI 模型的灵活性和适应性。例如,一个智能客服机器人可以先查询可用的工作流,然后根据用户提出的问题类型,选择“问题分类”或“答案生成”等不同的工作流来处理。这种动态发现能力避免了硬编码工作流选择逻辑,降低了维护成本,并允许快速集成新的工作流。技术上,该功能通过调用 Dify 平台的 API 来获取工作流信息,并将结果转换为 MCP 兼容的格式返回。

工作流按需执行

DifyWorkflow 的核心功能是能够按需执行 Dify 平台上预定义的工作流。通过 execute_workflow 命令,AI 模型可以指定要执行的工作流名称,并提供相应的输入数据。DifyWorkflow 会将输入数据传递给 Dify 工作流,执行完毕后将结果返回给 AI 模型。这种机制使得 AI 模型能够利用 Dify 强大的工作流引擎来完成各种复杂的任务,例如数据转换、内容生成、图像处理等。一个典型的应用场景是,AI 模型需要将一段英文文本翻译成中文,它可以调用 Dify 上预先配置好的“翻译”工作流,并将英文文本作为输入,DifyWorkflow 会自动完成翻译过程,并将翻译结果返回给 AI 模型。输入参数 input 对应 Dify Workflow 中预定义的 "message" 变量。

Dify集成简化

DifyWorkflow 极大地简化了 AI 模型与 Dify 平台的集成过程。开发者无需编写复杂的代码来调用 Dify API,只需通过 MCP 协议发送简单的命令即可完成工作流的查询和执行。这降低了 AI 模型与 Dify 集成的技术门槛,使得更多的开发者能够轻松地利用 Dify 强大的功能。例如,一个开发者想要构建一个能够自动生成文章摘要的 AI 应用,他可以使用 Dify 创建一个“文章摘要”工作流,然后使用 DifyWorkflow 将该工作流集成到自己的 AI 应用中。整个过程无需编写任何 Dify 相关的 API 调用代码,大大缩短了开发周期。DifyWorkflow 通过环境变量 DIFY_WORKFLOW_NAME 和 DIFY_API_KEYS 来配置需要暴露的工作流和对应的 API 密钥,简化了配置管理。