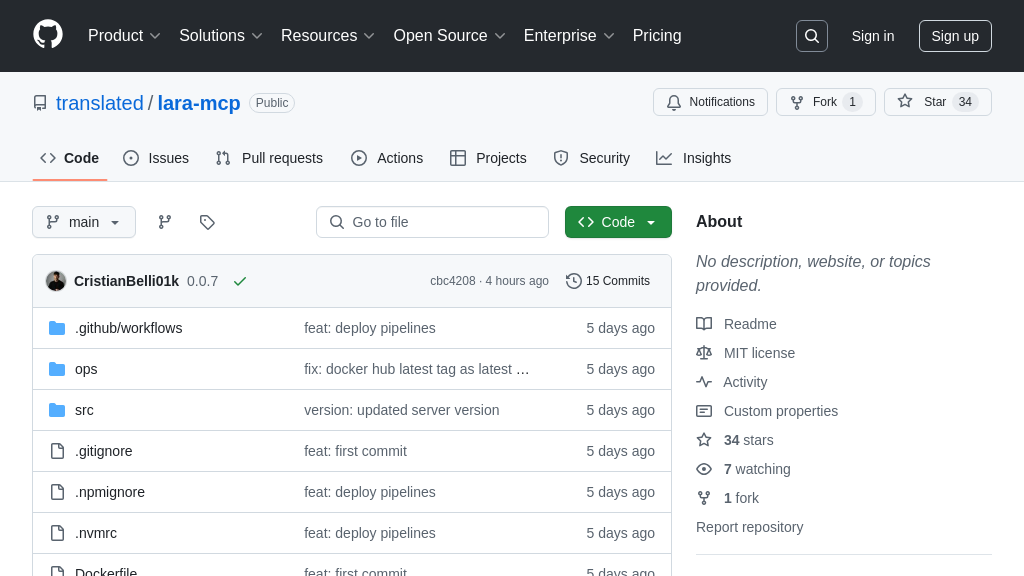

lara-mcp 解决方案概述

lara-mcp 是一个 MCP 服务器,旨在为 AI 模型提供强大的翻译能力。它充当 AI 应用和 Lara Translate API 之间的桥梁,使 AI 能够执行专业的翻译任务。该服务器支持语言自动检测、上下文感知翻译和自定义指令,从而优化翻译质量。通过与 AI 应用集成,lara-mcp 允许 AI 无缝地将高质量翻译整合到工作流程中,无需直接实现翻译 API。

开发者可以通过 Docker、NPX 或从源代码构建来安装和设置 lara-mcp。它提供了一个 translate 工具,该工具接受包含文本、翻译指令和上下文信息的输入,并返回保持原始结构的翻译文本块。使用 lara-mcp 的核心价值在于,它简化了 AI 模型与专业翻译服务的集成,提升了 AI 应用处理多语言内容的能力。

lara-mcp 核心能力

语言检测自动化

Lara Translate MCP Server 能够自动检测源语言,无需在每次翻译请求中显式指定。这项功能极大地简化了AI模型与翻译服务的集成过程,尤其是在处理用户生成内容或多语言文档时。AI模型可以专注于内容分析和处理,而将语言识别的复杂性交给Lara Translate MCP Server。例如,一个聊天机器人可以利用此功能自动检测用户输入的语言,并将其翻译成客服人员使用的语言,从而实现无缝的多语言沟通。该功能通过调用Lara Translate API的语言检测接口实现,并作为翻译流程的预处理步骤。source_hint参数可以为语言检测提供指导,提高准确性。

上下文感知翻译

Lara Translate MCP Server 允许AI模型提供上下文提示,从而显著提高翻译质量。通过提供关于翻译文本主题、领域或使用场景的额外信息,Lara Translate API 可以生成更准确、更自然的翻译结果。例如,在翻译一篇关于医学研究的论文时,提供“医学”作为上下文可以确保专业术语得到正确的翻译。这种上下文感知能力对于需要高度精确翻译的专业领域至关重要。在技术实现上,上下文信息通过context参数传递给Lara Translate API,API利用这些信息调整其翻译模型,以生成更符合语境的翻译结果。

定制化翻译指令

Lara Translate MCP Server 支持通过自定义指令微调翻译行为。AI模型可以向Lara Translate API 发送特定的指令,例如指定翻译的语气(正式、非正式)、风格(技术性、文学性)或目标受众。这种定制化能力使得AI模型能够根据不同的应用场景和用户需求生成高度个性化的翻译结果。例如,一个营销AI可以使用此功能将广告文案翻译成多种语言,并根据不同国家和地区的文化习惯调整翻译风格。指令通过instructions参数以字符串数组的形式传递给Lara Translate API,API根据这些指令调整其翻译策略。

多语言对支持

Lara Translate MCP Server 基于 Lara Translate API,支持多种语言之间的翻译。这意味着AI模型可以利用该MCP Server 将文本翻译成各种目标语言,从而实现全球化的应用场景。无论是将产品文档翻译成多种语言,还是为多语言客户提供实时翻译支持,Lara Translate MCP Server 都能提供强大的翻译能力。该功能直接依赖于Lara Translate API 提供的语言支持,用户可以参考Lara Translate API 的文档获取完整的语言列表。AI模型通过在请求中指定target参数来选择目标语言。