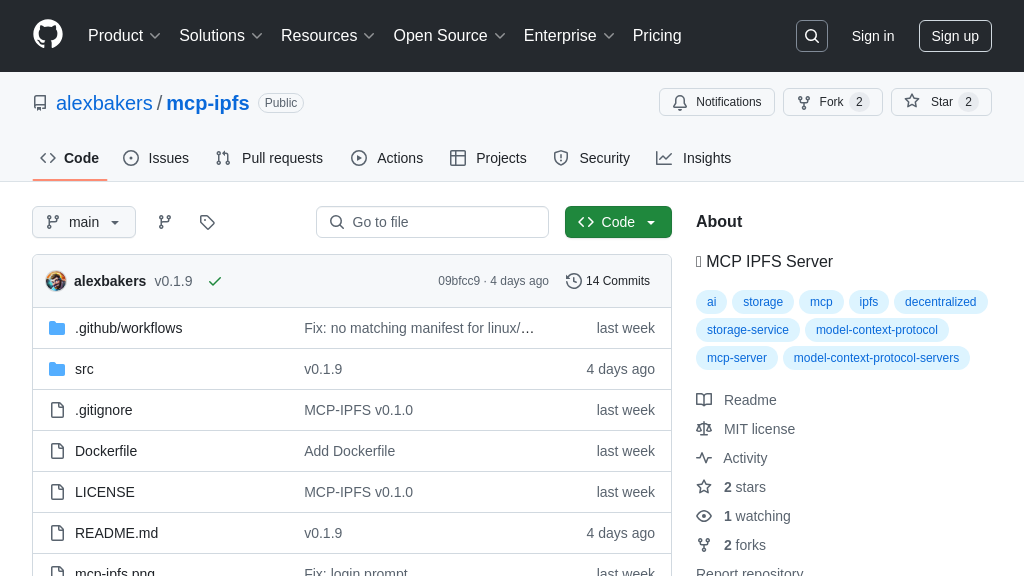

mcp-ipfs

mcp-ipfs 是一个 MCP 服务器,通过封装 w3 CLI,使 AI 模型和 MCP 客户端能够轻松与 storacha.network (IPFS) 交互,实现去中心化存储的数据管理、认证和委托等操作。

mcp-ipfs 解决方案概述

mcp-ipfs 是一款 MCP 服务器,旨在通过封装 w3 命令行工具,连接 AI 模型与 storacha.network 分布式存储平台。它使 MCP 客户端(如语言模型)能够无缝管理 storacha.network 空间、上传下载数据、处理委托、管理密钥和执行多种高级存储操作,无需直接处理 w3 CLI 的复杂性。通过标准化的 MCP 接口,AI 模型可以直接调用这些强大的存储功能,极大地扩展了其与去中心化数据交互的能力。核心价值在于提供了一个即用型桥梁,简化了 AI 应用与 IPFS/Filecoin 生态系统(通过 storacha.network)的集成。该服务器基于 Node.js 构建,可通过 NPX 或 Docker 轻松集成到 MCP 客户端配置中,实现快速部署和使用。

mcp-ipfs 核心能力

无缝认证与账户管理

mcp-ipfs 服务器通过封装 w3 CLI 的认证命令,为 AI 模型和 MCP 客户端提供了与 storacha.network (web3.storage) 进行安全交互的基础。核心认证工具是 w3_login,它利用预配置的电子邮件地址(通过 W3_LOGIN_EMAIL 环境变量提供)来验证客户端身份。一旦初始 w3 login 在宿主环境或 Docker 容器构建过程中完成(需要一次性邮件验证),服务器就能代表客户端进行后续操作。此外,w3_account_ls 工具允许客户端查询当前的授权状态和关联账户信息,确保操作是在正确的身份下执行。这项功能解决了 AI 应用需要以编程方式、无需人工干预地访问受保护的去中心化存储资源的难题。它使得 AI 模型能够自主管理其存储凭证,为自动化工作流(如定期数据备份或模型更新)奠定了安全基础,是实现 AI 与 Web3 存储无缝集成的关键第一步。

使用场景示例:一个部署在云端的 AI 代理,在执行每日数据同步任务前,首先会调用 mcp-ipfs 提供的 w3_account_ls 工具检查其 storacha.network 登录状态。如果未登录或凭证过期,它可以(理论上,若 w3_login 支持非交互式流程或已有有效会话)尝试重新认证,确保后续的数据上传操作能够成功执行。

去中心化空间管理

mcp-ipfs 使得 AI 模型能够直接管理其在 storacha.network 上的存储“空间”(Spaces)。空间是 web3.storage 中用于组织和隔离数据的基本单位,类似于项目文件夹或独立的存储桶。该服务器通过封装一系列 w3 space 子命令(如 w3_space_ls 列出所有可用空间, w3_space_use 切换当前活动空间, w3_space_info 获取空间详情, w3_space_add 邀请成员或注册新空间, w3_space_provision 为空间分配存储提供者)作为 MCP 工具,赋予了 AI 客户端程序化控制存储结构的能力。这种能力对于需要处理多个项目、数据集或用户数据的 AI 应用至关重要。AI 模型不再需要依赖预先手动配置好的固定空间,而是可以根据任务需求动态创建、选择或查询空间信息,极大地提高了其操作灵活性和自主性。这为开发者构建能够自我管理存储资源的复杂 AI 系统提供了便利,简化了多租户或多项目场景下的数据隔离和管理。

使用场景示例:一个多任务 AI 助手在处理来自不同用户的请求时,可以为每个用户或每个重要任务调用 w3_space_add (假设已注册) 或 w3_space_provision 创建一个独立的 storacha.network 空间。在处理特定用户请求时,它会先使用 w3_space_use 切换到该用户的空间,确保数据隔离和正确的访问权限,然后再进行数据上传或下载。

IPFS 数据核心操作

mcp-ipfs 的核心价值在于其简化了 AI 模型与 IPFS 网络(通过 storacha.network)之间的数据交互。它将底层的 w3 CLI 数据管理命令封装为易于使用的 MCP 工具,主要包括:w3_up 用于将本地文件或目录上传到当前活动的 storacha.network 空间并获取其 IPFS 内容标识符 (CID);w3_ls 用于列出当前空间中的已上传内容;w3_rm 用于从空间中移除指定 CID 的内容;以及 w3_open 用于为已上传的 CID 生成一个可通过 web 访问的 w3s.link URL。这些工具使 AI 模型能够像操作本地文件系统一样,方便地将生成的数据(如模型权重、训练日志、输出结果)持久化到去中心化存储网络,或从中检索所需数据。这解决了 AI 应用在处理大规模数据、需要数据持久性和可验证性、或希望利用 IPFS 内容寻址优势时的存储挑战。开发者可以轻松集成这些功能,让 AI 模型具备直接读写 IPFS 的能力,而无需处理复杂的 IPFS 协议或 storacha.network API 细节。需要注意的是,使用 w3_up 等涉及本地文件的工具时,必须提供正确的文件系统绝对路径,在 Docker 环境下还需确保相关目录已正确挂载。

使用场景示例:一个训练大规模机器学习模型的 AI 任务完成后,使用 w3_up 工具将最终的模型检查点文件上传到其指定的 storacha.network 项目空间。上传成功后,它会记录返回的 IPFS CID。后续,另一个推理服务或评估脚本可以使用这个 CID,通过 mcp-ipfs (或其他 IPFS 客户端) 下载该模型文件进行部署或分析。同时,开发者可以使用 w3_open 工具获取一个公开链接,方便团队成员预览或访问该模型文件。