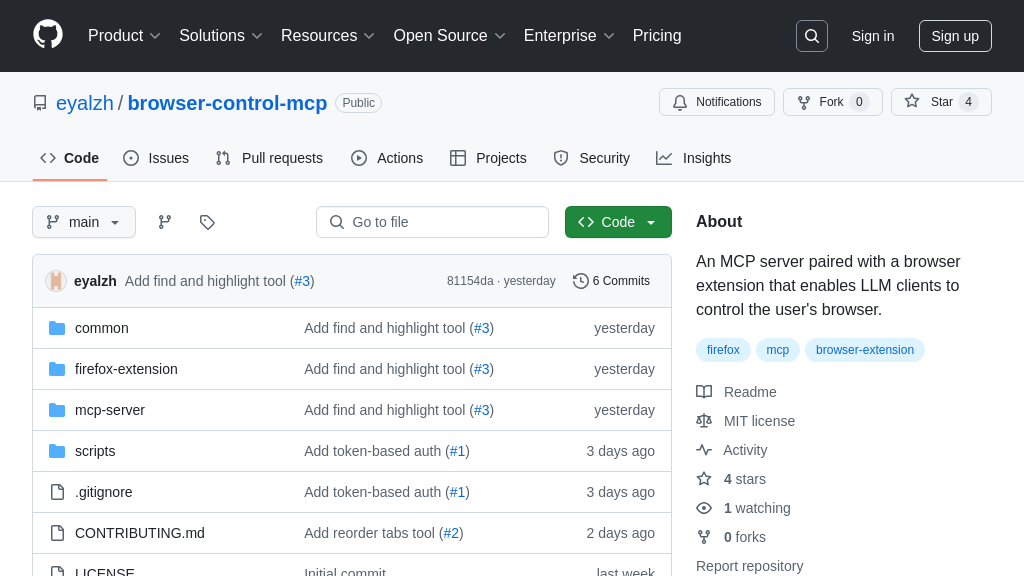

mcp-simple-openai-assistant

mcp-simple-openai-assistant:通过 MCP 协议连接 Claude 与 OpenAI Assistants 的服务器,赋能 AI 模型。

mcp-simple-openai-assistant 解决方案概述

mcp-simple-openai-assistant 是一个 MCP 服务器,旨在弥合 AI 模型与 OpenAI Assistants 之间的鸿沟。它允许像 Claude 这样的客户端通过模型上下文协议 (MCP) 创建并与 OpenAI Assistants 交互,从而扩展了 Claude 的功能。该服务器支持创建、修改和列出 OpenAI Assistants,启动新的对话线程,以及发送消息和接收回复。

由于 OpenAI Assistants 可能存在客户端超时问题,该方案采用两阶段方法:首先发送消息启动处理,然后检索响应。这提供了一种临时解决方案,直到 MCP 协议和客户端实现更完善的长时处理机制。通过简单的 pip 安装和配置 OpenAI API 密钥,开发者可以轻松地将此服务器集成到他们的 MCP 环境中,使他们的 AI 模型能够利用 OpenAI GPTs Assistants 的强大功能。

mcp-simple-openai-assistant 核心能力

OpenAI助手集成

mcp-simple-openai-assistant 作为一个MCP服务器,其核心功能在于将OpenAI的强大助手功能无缝集成到其他AI模型中,例如Claude。它允许这些模型通过标准化的MCP协议创建、操作和与OpenAI助手交互,极大地扩展了它们的能力边界。该服务器充当了一个桥梁,使得原本孤立的AI生态系统能够互相连接,共享资源。例如,Claude可以通过这个服务器利用OpenAI助手来执行特定的任务,如代码生成、数据分析或内容创作,而无需直接集成OpenAI的API。这种集成方式不仅简化了开发流程,还提高了AI模型的灵活性和适应性。技术上,该服务器通过Python实现,并依赖于OpenAI API密钥进行身份验证。

双阶段消息处理

由于OpenAI助手处理消息可能需要较长时间,mcp-simple-openai-assistant 采用了双阶段方法来解决潜在的客户端超时问题。第一阶段,客户端(如Claude)发送消息给OpenAI助手,启动处理过程。第二阶段,客户端稍后再次调用服务器,以检索处理结果。这种异步处理方式确保了即使OpenAI助手需要几分钟才能完成任务,客户端也能保持稳定连接,避免因超时而中断。这种机制对于需要长时间运行的任务至关重要,例如复杂的计算或大规模数据处理。它也突显了MCP协议在处理异步操作方面的灵活性。未来,MCP协议和客户端可以通过实现keep-alive机制来进一步优化这一过程。

助手生命周期管理

mcp-simple-openai-assistant 提供了全面的OpenAI助手生命周期管理功能。它允许用户通过MCP协议创建新的助手,列出已存在的助手,并修改助手的配置。这意味着AI模型可以通过编程方式动态地调整其使用的OpenAI助手,以适应不同的任务需求。例如,Claude可以根据当前的任务类型选择不同的OpenAI助手,如专门用于代码生成的助手或专门用于文本摘要的助手。这种动态管理能力极大地提高了AI模型的效率和适应性。技术上,该服务器通过调用OpenAI API来实现这些功能,并提供了简单的API接口供客户端调用。

集成优势

mcp-simple-openai-assistant 的主要优势在于其简化了AI模型与OpenAI助手之间的集成过程。通过使用MCP协议,它提供了一个标准化的接口,使得不同的AI模型可以轻松地利用OpenAI的强大功能,而无需关心底层的API细节。这种集成方式降低了开发成本,提高了互操作性,并促进了AI生态系统的发展。此外,该服务器还处理了与OpenAI API通信的复杂性,包括身份验证、请求格式化和错误处理,从而减轻了客户端的负担。例如,一个小型AI创业公司可以使用该服务器来快速集成OpenAI助手,而无需投入大量资源来学习和维护OpenAI API。