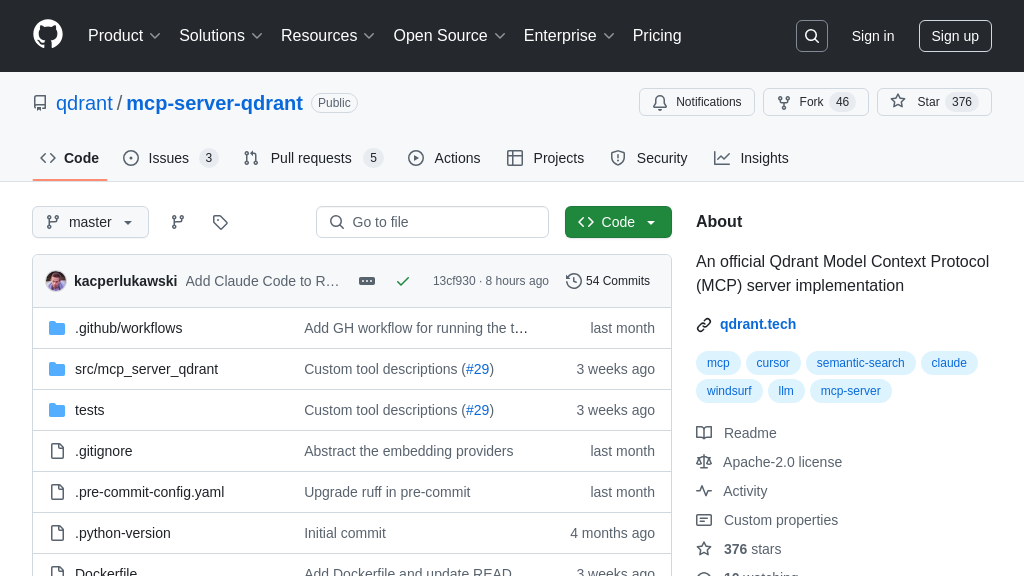

mcp-server-qdrant 解决方案概述

mcp-server-qdrant 是一个基于 Qdrant 向量搜索引擎的 MCP 服务器,为 AI 模型提供语义记忆层。它通过 qdrant-store 和 qdrant-find 工具,实现信息的存储和检索。开发者可以使用它轻松地将信息存储到 Qdrant 数据库中,并根据查询检索相关信息,从而增强 AI 模型的上下文理解能力。

该服务器支持多种传输协议,包括标准输入/输出和 Server-Sent Events (SSE),方便本地和远程客户端连接。通过简单的环境变量配置,即可与 Claude、Cursor 等 MCP 客户端无缝集成,实现代码片段的存储和检索等功能。使用 mcp-server-qdrant,开发者可以显著提升 AI 应用的智能化水平,并简化 AI 模型与外部知识库的集成过程。它还修复了一个潜在的安全漏洞 (CVE-2024-4994),建议更新到 0.7.2 或更高版本。

mcp-server-qdrant 核心能力

语义记忆存储与检索

mcp-server-qdrant 作为一个 MCP 服务器,其核心功能是为 AI 模型提供语义记忆能力。它利用 Qdrant 向量搜索引擎,允许 AI 模型存储和检索信息,从而增强模型的上下文理解和长期记忆。该服务器通过 qdrant-store 工具接收需要存储的信息和可选的元数据,并将信息嵌入为向量存储在 Qdrant 数据库中。当 AI 模型需要检索信息时,通过 qdrant-find 工具发送查询,服务器将查询嵌入为向量,并在 Qdrant 数据库中进行相似性搜索,返回相关的信息。这种机制使得 AI 模型能够记住并利用先前的信息,从而做出更明智的决策。

例如,在一个代码生成的场景中,AI 模型可以使用 qdrant-store 存储常用的代码片段及其描述,例如 "用于计算斐波那契数列的函数"。当模型需要生成类似功能的代码时,可以使用 qdrant-find 查询 "计算数列的函数",服务器将返回相关的代码片段,模型可以参考这些片段生成新的代码,提高效率和准确性。

与 Qdrant 无缝集成

mcp-server-qdrant 的一个关键优势是与 Qdrant 向量搜索引擎的无缝集成。Qdrant 提供高性能的向量相似性搜索能力,使得服务器能够快速准确地检索相关信息。服务器利用 Qdrant 的 API 进行向量存储和搜索,无需额外的配置或集成工作。这种集成简化了 AI 模型的开发流程,开发者可以专注于模型本身的逻辑,而无需关心底层的数据存储和检索细节。

例如,在一个聊天机器人的应用中,可以将用户的历史对话存储在 Qdrant 中。当用户提出新的问题时,聊天机器人可以使用 qdrant-find 检索相关的历史对话,从而更好地理解用户的意图,并给出更个性化的回答。Qdrant 的高性能保证了即使在大量对话数据的情况下,也能快速检索到相关信息。

支持多种传输协议

mcp-server-qdrant 支持多种传输协议,包括标准输入/输出 (stdio) 和服务器发送事件 (SSE)。这种灵活性使得服务器可以与各种 MCP 客户端进行通信,无论客户端是本地应用还是远程服务。stdio 适用于本地客户端,例如在开发和调试阶段,而 SSE 适用于远程客户端,例如在云端部署的 AI 模型。通过 --transport 标志可以指定使用的传输协议,方便开发者根据实际需求进行配置。

例如,可以使用 stdio 在本地测试 AI 模型与 mcp-server-qdrant 的集成,验证信息存储和检索的功能是否正常。在将 AI 模型部署到云端后,可以使用 SSE 协议与远程的 mcp-server-qdrant 服务器进行通信,实现 AI 模型的长期记忆功能。

技术实现

mcp-server-qdrant 使用 Python 编写,并利用 FastEmbed 模型进行文本嵌入。FastEmbed 模型可以将文本转换为向量,用于在 Qdrant 中进行相似性搜索。服务器通过环境变量进行配置,例如 Qdrant 的 URL、API 密钥和集合名称。此外,服务器还支持使用 Docker 进行部署,方便开发者快速搭建和运行环境。这种技术实现使得 mcp-server-qdrant 易于使用和部署,降低了开发者的学习成本。