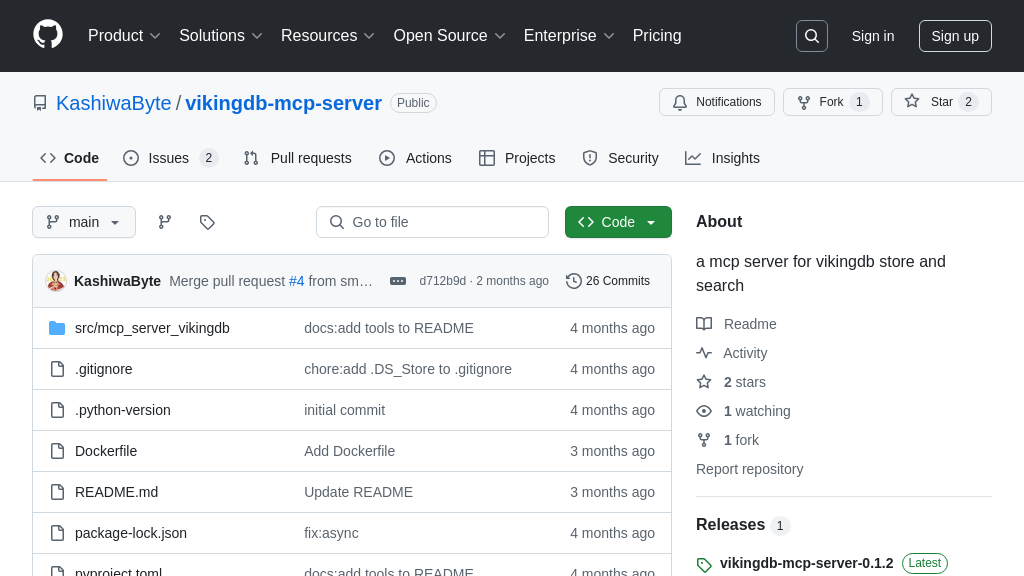

mcp-server-weaviate

mcp-server-weaviate:连接 AI 模型与 Weaviate 向量数据库的 MCP 服务器。

mcp-server-weaviate 解决方案概述

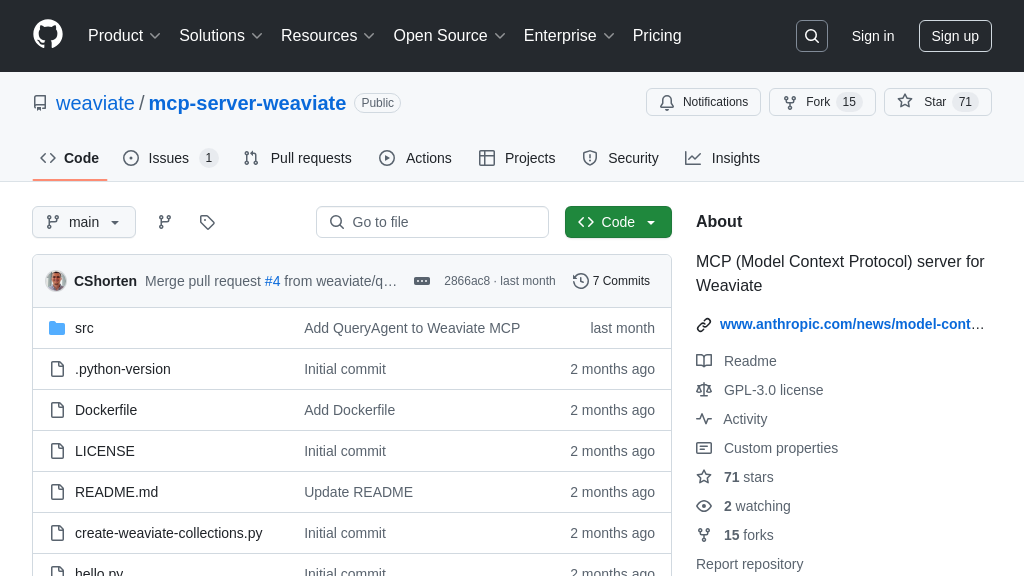

mcp-server-weaviate 是一个专为 Weaviate 向量数据库设计的 MCP 服务器,它使得 AI 模型能够安全高效地访问和利用 Weaviate 中的数据。通过简单的配置,开发者可以轻松地将此服务器集成到 Claude 等 AI 客户端中,从而扩展 AI 模型的功能。该服务器允许 AI 模型执行诸如语义搜索和数据存储等操作,极大地增强了 AI 在知识检索和上下文理解方面的能力。它通过标准 MCP 协议与 AI 模型通信,支持灵活的部署和配置选项。使用 mcp-server-weaviate,开发者可以充分利用 Weaviate 的强大功能,构建更智能、更具洞察力的 AI 应用。该解决方案使用 Python 构建,并通过环境变量进行配置,方便集成到各种开发环境中。

mcp-server-weaviate 核心能力

Weaviate 向量搜索集成

mcp-server-weaviate 的核心功能是无缝集成 Weaviate 向量数据库,为 AI 模型提供强大的语义搜索能力。它允许模型通过 MCP 协议访问存储在 Weaviate 中的向量化数据,从而实现基于上下文的检索。该服务器充当 AI 模型和 Weaviate 数据库之间的桥梁,将模型的查询转换为 Weaviate 可以理解的向量搜索请求,并将结果返回给模型。这种集成极大地增强了 AI 模型处理复杂查询和理解上下文的能力,尤其是在需要从大量非结构化数据中提取信息时。例如,一个 AI 助手可以使用 mcp-server-weaviate 从存储在 Weaviate 中的文档库中检索相关信息,以回答用户的问题或完成任务。技术实现上,服务器使用 Weaviate 的 Python 客户端库与数据库进行交互,并通过环境变量进行配置,包括 Weaviate 的 URL、API 密钥以及搜索和存储集合的名称。

上下文数据持久化

该服务器支持将 AI 模型的上下文数据持久化到 Weaviate 数据库中。这意味着模型可以将对话历史、用户偏好或其他相关信息存储在 Weaviate 中,以便在后续交互中使用。这对于构建具有记忆和个性化的 AI 应用至关重要。通过将上下文数据存储为向量,模型可以利用 Weaviate 的向量搜索能力来快速检索相关信息,从而提高响应速度和准确性。例如,一个聊天机器人可以使用此功能来记住用户的先前对话,并根据用户的历史行为提供定制化的建议。技术实现上,服务器提供了一个 API 接口,允许 AI 模型将上下文数据作为向量发送到 Weaviate,并指定存储的集合名称。

灵活的数据管理

mcp-server-weaviate 提供了灵活的数据管理功能,允许开发者自定义数据在 Weaviate 中的存储和检索方式。开发者可以根据自己的需求定义 Weaviate 的 schema,并使用不同的向量化方法来表示数据。这种灵活性使得开发者可以针对特定的应用场景优化性能和准确性。例如,开发者可以使用不同的距离度量方法来调整搜索结果的相关性,或者使用不同的向量化模型来提高数据的表示质量。技术实现上,服务器允许开发者通过配置文件指定 Weaviate 的 schema 和向量化参数,并提供了 API 接口来管理数据对象。

技术实现:基于Python的轻量级服务器

mcp-server-weaviate 基于 Python 构建,是一个轻量级的 MCP 服务器。它易于安装和配置,并且可以轻松地集成到现有的 AI 开发流程中。使用 Python 作为开发语言使得开发者可以利用丰富的 Python 生态系统,例如用于数据处理和机器学习的库。服务器的设计注重性能和可扩展性,可以处理大量的并发请求。此外,服务器还提供了详细的日志记录和监控功能,方便开发者进行调试和优化。通过使用标准输入/输出或 HTTP/SSE 等传输机制,服务器可以与各种 AI 模型和客户端进行通信。