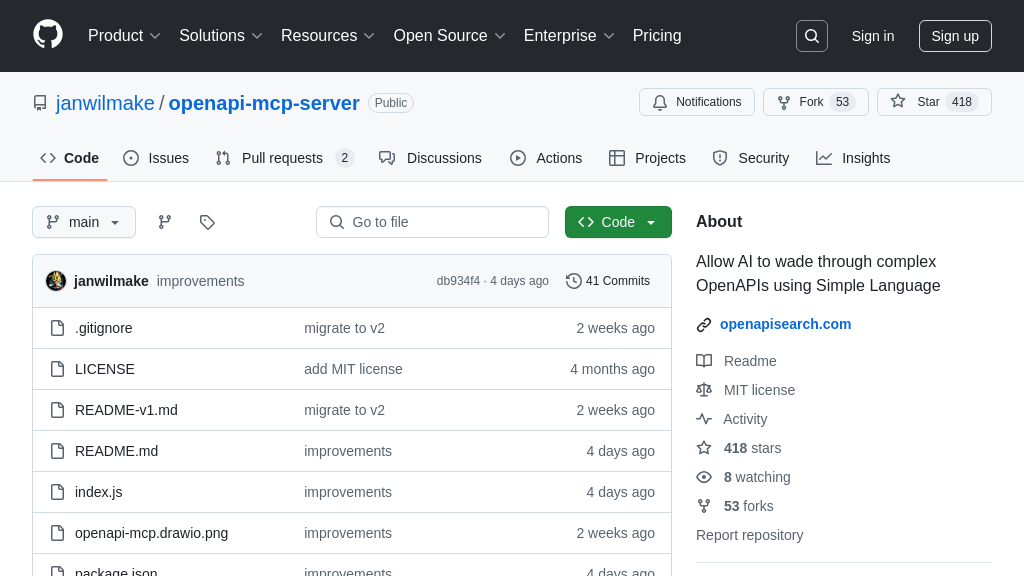

openapi-mcp-server 解决方案概述

openapi-mcp-server 是一款专为 Claude 和 Cursor 等 AI 模型设计的 MCP 服务器,它赋予 AI 通过自然语言探索和理解复杂 OpenAPI 规范的能力。该服务器的核心价值在于简化了 AI 与 API 的交互,开发者无需深入研究繁琐的 API 文档,即可让 AI 快速获取 API 的概述和操作细节。

通过 openapi-mcp-server,AI 可以轻松查找 Stripe API 的信息,或解释如何使用 GitHub API 的存储库端点。它支持 JSON 和 YAML 格式的 OpenAPI 规范,并已在 Claude Desktop 和 Cursor 上进行了测试。该服务器通过与 oapis.org 集成,提供强大的 OpenAPI 规范搜索和探索功能,极大地提升了 AI 在 API 相关任务中的效率和准确性。开发者可以通过简单的 npx 命令快速安装和初始化该服务器,并将其无缝集成到现有的 MCP 客户端中。

openapi-mcp-server 核心能力

OpenAPI 规范检索

openapi-mcp-server 的核心功能是允许 AI 模型通过自然语言检索和浏览 OpenAPI 规范。它充当 AI 模型和 oapis.org 上的 OpenAPI 规范库之间的桥梁。当 AI 模型需要了解特定 API 的结构和功能时,它可以向 openapi-mcp-server 发送请求,指定所需的 OpenAPI 标识符。服务器随后会从 oapis.org 检索相应的规范,并将其以易于理解的格式提供给 AI 模型。这使得 AI 模型能够快速获取 API 的概述和详细信息,而无需手动解析复杂的 OpenAPI 文件。例如,AI 模型可以使用此功能来查找有关 Stripe API 的信息,或者了解如何使用 GitHub API 的存储库端点。技术上,服务器通过 HTTP 请求从 oapis.org 获取 OpenAPI 规范,并使用 JSON 或 YAML 格式将其返回给客户端。

API 操作细节提取

除了检索整个 OpenAPI 规范之外,openapi-mcp-server 还可以提取特定 API 操作的详细信息。这对于 AI 模型需要了解特定端点的工作方式或参数时非常有用。AI 模型可以向服务器发送请求,指定所需的 OpenAPI 标识符和操作 ID。服务器随后会解析 OpenAPI 规范,提取有关该操作的详细信息,例如其描述、参数、请求体和响应。然后,服务器将这些信息以易于理解的格式提供给 AI 模型。例如,AI 模型可以使用此功能来了解如何使用 GitHub API 的 create repository 端点,或者了解 Stripe API 的 charge customer 操作需要哪些参数。技术上,服务器使用 OpenAPI 解析器库来解析规范,并使用 JSON 或 YAML 格式返回提取的信息。

简化 API 探索流程

openapi-mcp-server 极大地简化了 AI 模型探索 API 的流程。传统上,AI 模型需要手动下载和解析 OpenAPI 规范,这既耗时又容易出错。通过 openapi-mcp-server,AI 模型可以使用自然语言请求来查找和理解 API。这使得 AI 模型能够更快地集成新的 API,并更有效地利用现有 API。例如,AI 模型可以使用此功能来自动生成 API 客户端代码,或者根据 API 规范自动生成测试用例。此外,openapi-mcp-server 还可以帮助 AI 模型发现新的 API,并了解它们的功能。例如,AI 模型可以使用此功能来查找与特定领域相关的 API,或者查找提供特定功能的 API。技术上,服务器使用缓存机制来提高性能,并减少对 oapis.org 的请求次数。

集成优势

openapi-mcp-server 的一个关键优势是其易于集成到现有的 MCP 生态系统中。它可以通过标准的 MCP 客户端进行访问,例如 Claude Desktop 和 Cursor。这意味着开发者可以轻松地将 openapi-mcp-server 添加到他们的 AI 工作流程中,而无需进行大量的代码更改。此外,openapi-mcp-server 支持 JSON 和 YAML 格式,这使得它可以与各种不同的 AI 模型和工具进行互操作。通过提供一个标准化的接口来访问 OpenAPI 规范,openapi-mcp-server 促进了 AI 模型和 API 之间的互操作性,并降低了集成成本。