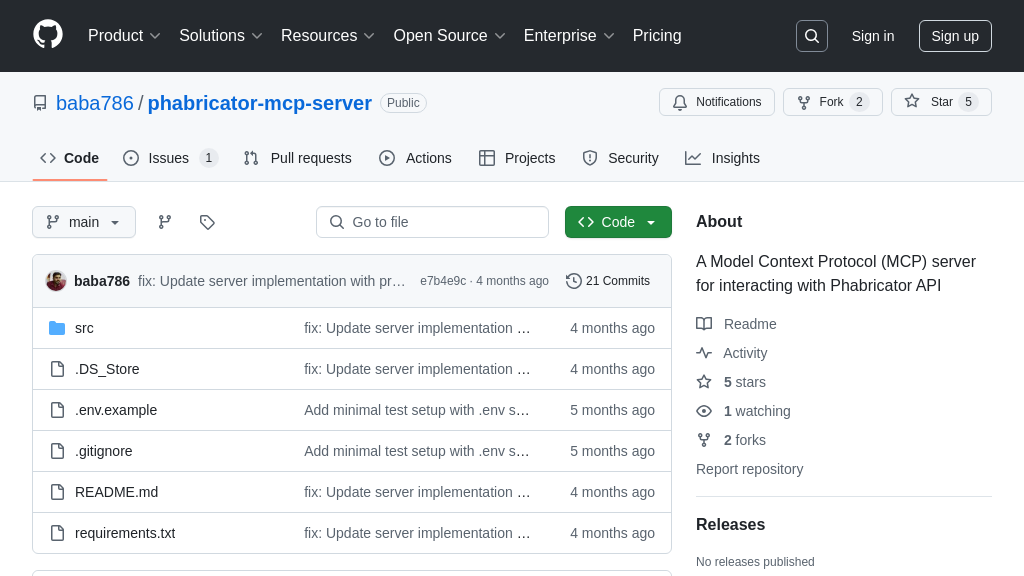

phabricator-mcp-server

phabricator-mcp-server:连接AI模型与Phabricator的MCP服务器,简化任务管理和项目集成。

phabricator-mcp-server 解决方案概述

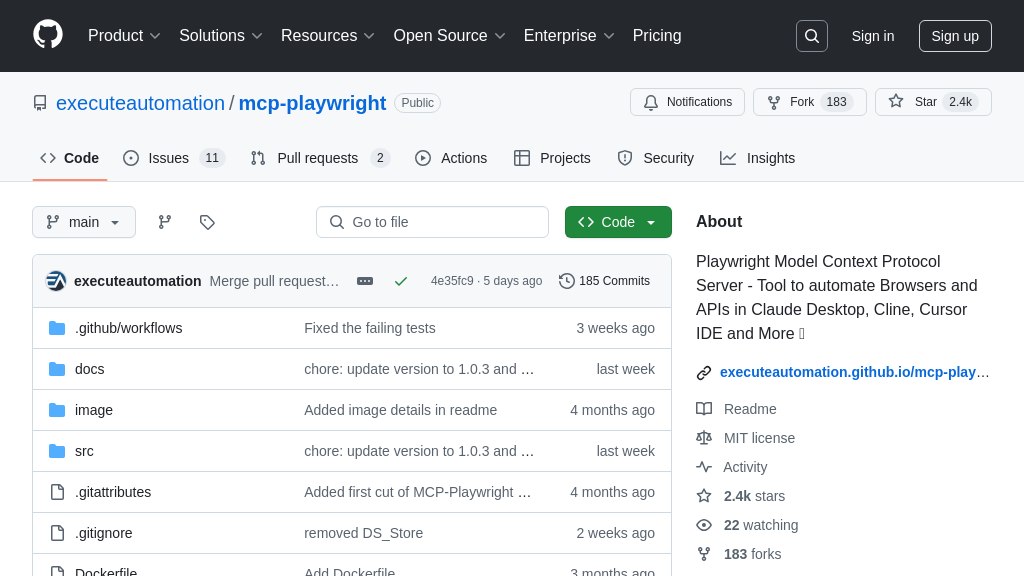

phabricator-mcp-server 是一款 MCP 服务器,旨在通过标准化的接口,连接大型语言模型(LLM)与 Phabricator 的强大功能。它允许 AI 模型安全地访问和操作 Phabricator 中的任务管理、项目信息和用户详情等核心数据。

该服务器通过简单的 API 调用,使 AI 能够检索特定任务的详细信息,从而增强 AI 在项目管理和协作方面的能力。开发者可以利用此解决方案,构建能够理解项目上下文、自动执行任务更新或提供智能建议的 AI 应用。

phabricator-mcp-server 基于 Python 实现,通过 HTTP 协议与客户端通信,易于安装和集成。它使用 Phabricator API 令牌进行身份验证,确保数据安全。该项目目前仍在积极开发中,未来将提供更多功能。

phabricator-mcp-server 核心能力

Phabricator 任务信息检索

phabricator-mcp-server 的核心功能是允许 AI 模型通过标准化的 MCP 接口检索 Phabricator 任务的详细信息。该功能通过 get-task 命令实现,AI 模型可以向服务器发送包含任务 ID 的请求,服务器会调用 Phabricator API 获取任务的标题、描述、状态、负责人等信息,并将这些信息以结构化的格式返回给 AI 模型。这使得 AI 模型能够理解和利用 Phabricator 中存储的任务信息,例如,AI 助手可以根据任务描述生成代码片段,或者根据任务状态提醒相关人员。该功能解决了 AI 模型直接访问和解析 Phabricator API 的复杂性问题,简化了 AI 模型与 Phabricator 的集成过程。技术实现上,服务器使用 Phabricator API token 进行身份验证,确保安全访问 Phabricator 数据。

标准化接口访问 Phabricator

该服务器提供了一个标准化的 MCP 接口,允许 AI 模型以统一的方式与 Phabricator 进行交互,而无需关心底层 API 的细节。这意味着,无论 Phabricator API 如何更新,只要 MCP 接口保持不变,AI 模型就可以继续正常工作。这种标准化降低了 AI 模型与 Phabricator 集成的维护成本,并提高了系统的稳定性。例如,一个 AI 驱动的项目管理工具可以使用该 MCP 服务器来创建、更新和查询 Phabricator 中的任务,而无需直接处理 Phabricator API 的复杂性。这种标准化接口对于构建可扩展和可维护的 AI 应用至关重要。服务器通过定义清晰的请求和响应格式来实现标准化,确保 AI 模型和 Phabricator 之间的数据交换是可靠和一致的。

简化 AI 模型集成

phabricator-mcp-server 的一个关键优势是简化了 AI 模型与 Phabricator 的集成过程。开发者无需编写复杂的代码来处理 Phabricator API 的身份验证、请求构建和响应解析,只需使用 MCP 客户端发送简单的请求即可。这大大降低了 AI 模型集成的门槛,使得更多的开发者能够利用 Phabricator 的数据来构建智能应用。例如,一个 AI 驱动的缺陷报告分析工具可以使用该 MCP 服务器来自动提取 Phabricator 中缺陷报告的关键信息,并生成修复建议。这种简化集成的方式加速了 AI 应用的开发和部署,并提高了开发效率。服务器通过提供简单的 API 和清晰的文档来简化集成过程,使得开发者可以快速上手并构建自己的 AI 应用。

技术实现

phabricator-mcp-server 使用 Python 编写,并依赖于 Phabricator API。服务器通过 HTTP 协议接收来自 MCP 客户端的请求,并使用 Phabricator API token 进行身份验证。服务器将请求转发到 Phabricator API,并将响应解析为 MCP 标准格式,然后返回给客户端。服务器使用 .env 文件来存储 Phabricator API token,以确保安全性。该服务器还提供了一个简单的客户端示例,方便开发者快速测试和集成。