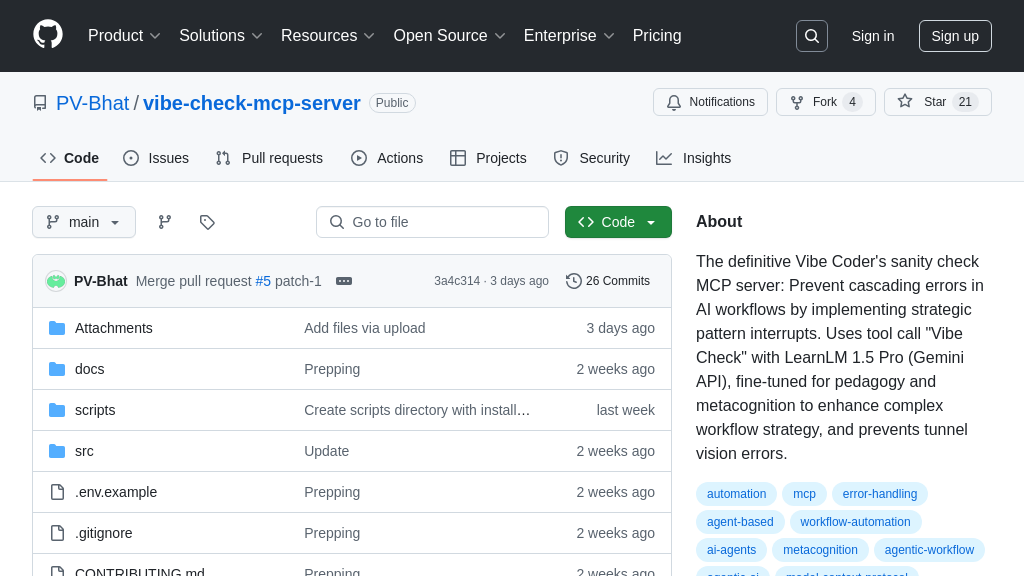

vibe-check-mcp-server

Vibe Check MCP Server:AI 的元认知守护者,防止思维定势和过度设计,让你的 AI 智能体更聪明!

vibe-check-mcp-server 解决方案概述

Vibe Check MCP Server 是一款用于增强AI代理工作流程的MCP服务器,它通过引入“Vibe Check”工具,为AI代理提供内置的自我纠正监督层。该服务器旨在解决AI在“Vibe Coding”中常见的模式惯性问题,例如隧道视野、范围蔓延和过度工程。

Vibe Check MCP Server 包含三个核心工具:vibe_check 用于中断AI的隧道视野,通过元认知提问打破思维定势;vibe_distill 作为一个元思考锚点,用于校准复杂的工作流程,防止过度设计;vibe_learn 则建立一个自我改进的反馈循环,帮助AI代理记录错误并改进语义回忆。

通过与LearnLM 1.5 Pro (Gemini API)的集成,Vibe Check MCP Server 能够战略性地中断AI工作流程中的错误模式,鼓励计划简化,并最大限度地减少上下文漂移。它通过Smithery或npm进行安装,并能与Claude等客户端无缝集成,为开发者提供一个强大的AI代理调试和优化工具。

vibe-check-mcp-server 核心能力

AI 流程的模式中断

vibe_check 工具作为一种模式中断机制,通过在 AI 工作流程的关键阶段(规划、实施或审查)引入元认知提问,打破 AI 模型的“隧道视野”。它接收当前阶段、用户的原始请求、AI 的当前计划以及可选的置信度评分作为输入。通过这种方式,vibe_check 能够促使 AI 模型暂停并重新评估其方法,防止其在错误的道路上越走越远。例如,当 AI 模型开始为一个简单的待办事项应用解释区块链基础知识时,vibe_check 可以介入,质疑这种复杂性是否必要,从而引导 AI 回到更简洁的解决方案。这有助于防止 AI 代理陷入单一方法,无法看到替代方案,最终导致范围蔓延和过度设计。

技术实现: vibe_check 使用 LearnLM 1.5 Pro (Gemini API) 进行微调,专门用于教学和元认知,以增强复杂工作流程策略。

简化计划的元认知锚点

vibe_distill 工具充当元认知锚点,旨在简化 AI 模型生成的复杂计划。它接收详细的计划和用户的原始请求作为输入,鼓励 AI 模型重新校准其工作流程,防止过度工程解决方案,并最大限度地减少代理中的上下文漂移。当 AI 模型的计划包含比整个技术规范更多的嵌套要点时,vibe_distill 可以帮助 AI 模型提炼其计划,专注于解决用户请求的核心问题。通过鼓励 AI 模型优先考虑简单性,vibe_distill 有助于确保 AI 解决方案保持与用户的意图对齐,并避免不必要的复杂性。

技术实现: vibe_distill 通过提示工程,引导AI模型识别和消除计划中的不必要步骤和复杂性,从而产生更简洁、更有效的解决方案。

自学习反馈回路

vibe_learn 工具实现了一个自学习反馈回路,允许 AI 模型记录和学习其错误,从而随着时间的推移提高其性能。它接收错误的简短描述、标准类别中的错误类别以及纠正错误的方式作为输入。通过将错误记录到 "Vibe Learn" 中,AI 模型可以改进语义回忆,并帮助监督 AI 随着时间的推移定位模式。例如,如果 AI 模型反复假设 "MCP" 的含义,而没有明确的用户上下文,则可以使用 vibe_learn 记录此错误,以便 AI 模型将来可以更好地处理歧义。

技术实现: vibe_learn 通过构建错误模式的知识库,使 AI 模型能够识别和避免将来重复这些错误,从而提高其整体可靠性和准确性。