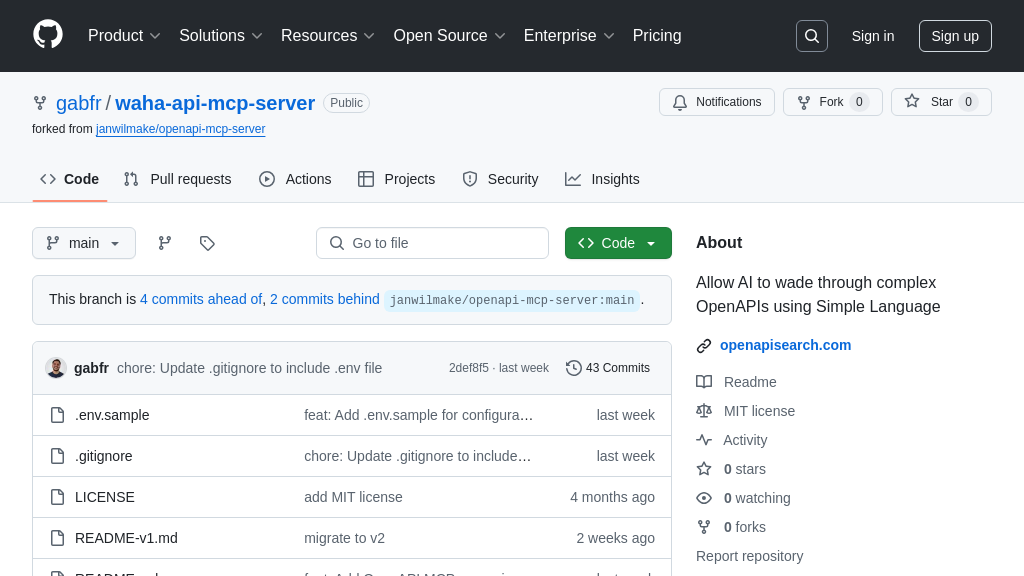

waha-api-mcp-server

waha-api-mcp-server:一款将 OpenAPI 转化为 AI 工具的 MCP 服务器,简化 AI 与 API 的集成。

waha-api-mcp-server 解决方案概述

waha-api-mcp-server 是一款专为AI模型设计的MCP服务器,它能够将OpenAPI规范转化为AI模型可用的工具。通过解析OpenAPI YAML文件,该服务器为每个API操作生成相应的MCP工具,使得AI能够轻松调用和利用外部API。它能处理路径参数、查询参数和请求体,并在AI模型(如Claude)调用工具时,发起真实的API请求。

该解决方案的核心价值在于简化了AI与API的集成过程,开发者无需编写复杂的集成代码,即可让AI模型具备调用各种API的能力。通过简单的配置,即可将现有的OpenAPI规范快速接入到AI工作流中。waha-api-mcp-server 通过HTTP/SSE等标准协议与AI模型交互,返回API调用结果供AI分析,从而实现更强大的AI应用。

waha-api-mcp-server 核心能力

OpenAPI驱动的工具生成

waha-api-mcp-server 的核心功能在于能够自动解析 OpenAPI 规范文件(YAML 格式),并将其中的每个 API 操作转化为可供 AI 模型(如 Claude)调用的独立工具。该服务器读取 OpenAPI 文件,提取所有路径和操作,并为每个操作创建带有适当输入模式的工具。这意味着开发者无需手动编写大量代码来将 API 接口暴露给 AI 模型,极大地简化了 AI 与现有 API 的集成过程。例如,如果 OpenAPI 文件中定义了一个获取用户列表的 API 接口,服务器会自动生成一个名为 listUsers 的工具,Claude 可以直接调用该工具来获取用户数据。

动态API调用与响应处理

当 AI 模型调用由 waha-api-mcp-server 生成的工具时,服务器会根据 OpenAPI 规范中的定义,动态地发起相应的 API 请求。服务器能够处理路径参数、查询参数和请求体等多种参数类型,确保请求的准确性和完整性。接收到 API 响应后,服务器会将响应数据返回给 AI 模型进行分析和处理。这种动态 API 调用和响应处理机制,使得 AI 模型能够与外部 API 进行实时的交互,从而实现更复杂的功能。例如,Claude 可以调用一个 createUser 工具来创建一个新用户,服务器会根据 OpenAPI 规范中的定义,向后端 API 发送一个包含用户信息的 POST 请求,并将 API 的响应返回给 Claude。

简化AI模型集成

waha-api-mcp-server 旨在简化 AI 模型与现有 API 的集成过程。通过将 OpenAPI 规范转化为 AI 模型可用的工具,该服务器降低了 AI 模型访问外部数据的门槛。开发者只需提供 OpenAPI 文件,即可快速地将 API 接口暴露给 AI 模型,无需编写大量的集成代码。此外,该服务器还提供了灵活的配置选项,允许开发者根据实际需求进行定制。例如,开发者可以通过环境变量来指定 OpenAPI 文件的路径,以及启用调试日志等功能。这种简化的集成方式,使得开发者能够更专注于 AI 模型的开发和应用,而无需花费大量时间在 API 集成上。

技术实现

waha-api-mcp-server 基于 JavaScript 开发,使用 Node.js 运行时环境。它依赖于 OpenAPI 规范解析库来读取和解析 OpenAPI 文件。服务器使用 HTTP/SSE 协议与 AI 模型进行通信,并通过 HTTP 协议与后端 API 进行交互。该服务器支持通过环境变量进行配置,例如 DEBUG 用于启用调试日志,OPENAPI_FILE 用于指定 OpenAPI 文件的路径。服务器的代码结构清晰,易于理解和维护。