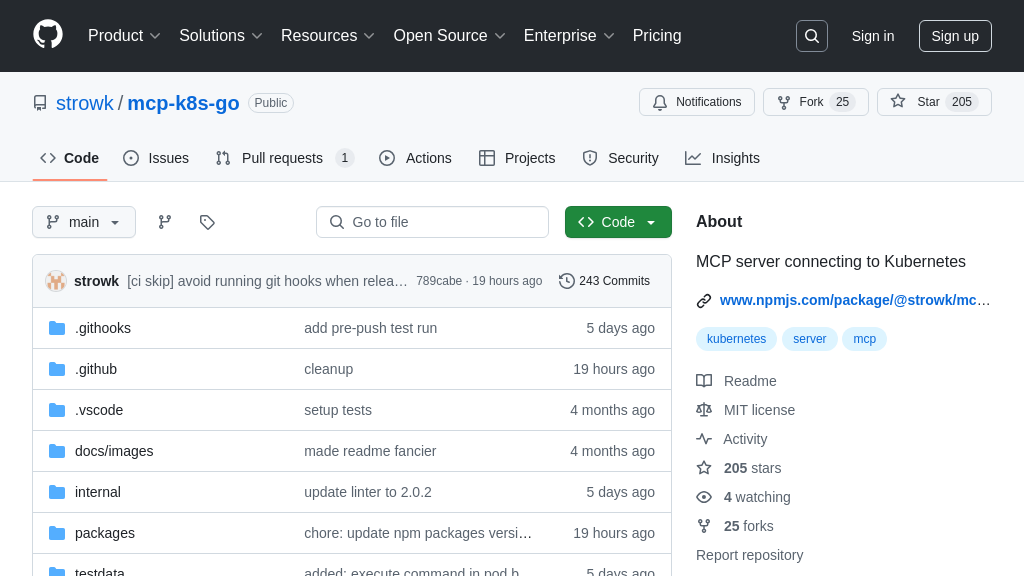

wikimedia-enterprise-model-context-protocol

基于Python的MCP服务器,连接AI模型与维基媒体企业API。

wikimedia-enterprise-model-context-protocol 解决方案概述

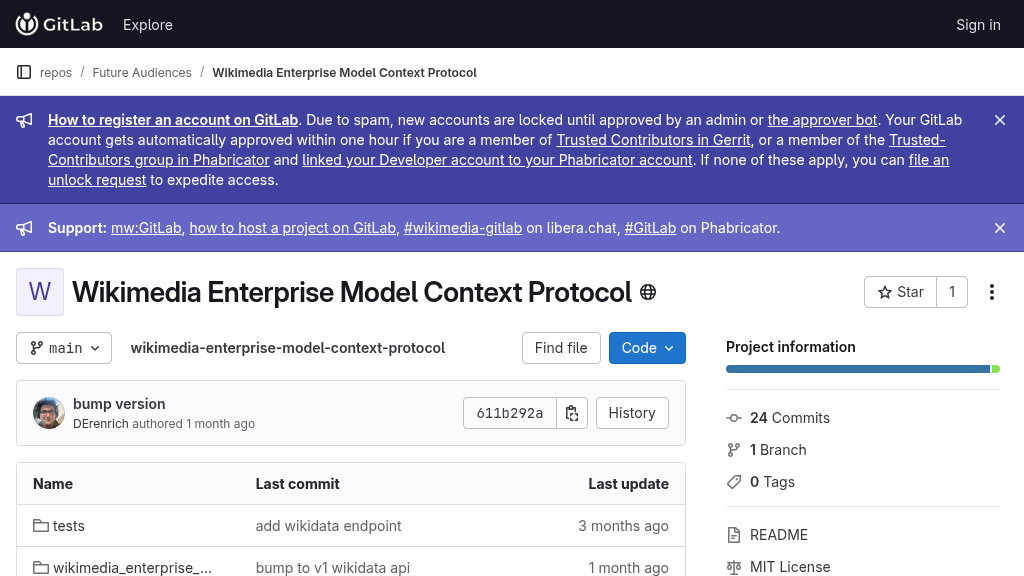

Wikimedia Enterprise Model Context Protocol是一个Python实现的MCP客户端,旨在连接AI模型与Wikimedia Enterprise API。它使AI模型能够安全地访问和利用维基媒体的企业级数据,从而增强模型的知识库和推理能力。开发者可以通过简单的配置,将此客户端集成到支持MCP协议的服务器,例如Anthropic Desktop。该客户端通过标准输入/输出流与服务器通信,并使用维基媒体企业API的用户名和密码进行身份验证。使用此解决方案,开发者可以轻松地将维基媒体的数据集成到他们的AI应用中,从而构建更智能、更强大的AI模型。该项目使用 Poetry 进行依赖管理,并采用 MIT 许可证。

wikimedia-enterprise-model-context-protocol 核心能力

安全访问维基媒体数据

该MCP解决方案的核心功能是为AI模型提供安全、受控的维基媒体企业API访问。它通过用户名和密码验证,确保只有授权的AI模型才能访问维基媒体的数据。这种安全机制对于保护维基媒体的数据资源至关重要,防止未经授权的访问和滥用。该解决方案使用.env文件存储敏感凭据,并要求用户在claude_desktop_config.json中配置正确的用户名和密码。这使得AI模型能够安全地从维基媒体获取信息,用于训练、推理或其他自然语言处理任务。例如,一个AI模型可以使用此功能来获取特定主题的最新维基百科文章,用于生成新闻摘要或回答用户提问。

标准化数据交互接口

该解决方案实现了模型上下文协议(MCP),为AI模型与维基媒体企业API之间的数据交互提供了一个标准化的接口。这意味着AI模型可以使用统一的方式请求和接收数据,而无需关心底层API的具体实现细节。这种标准化简化了AI模型的开发和集成过程,提高了开发效率。开发者可以使用uvx命令启动MCP服务器,并通过配置claude_desktop_config.json来指定维基媒体企业MCP服务器。例如,开发者可以使用此功能来构建一个AI助手,该助手可以根据用户的提问,从维基媒体获取相关信息,并以结构化的方式呈现给用户。

灵活的部署与集成

该MCP解决方案设计为易于部署和集成到现有的AI模型和基础设施中。它使用Python实现,并使用poetry进行依赖管理,使得安装和配置过程简单明了。该解决方案可以与Anthropic Desktop等MCP服务器集成,为AI模型提供即插即用的数据访问能力。开发者只需要克隆代码仓库,安装依赖,并配置相应的环境变量,即可开始使用。例如,一个企业可以使用此功能来构建一个内部知识库,该知识库可以从维基媒体获取最新的行业信息,并将其整合到企业现有的知识管理系统中。

技术实现

该解决方案使用Python编程语言实现,并依赖于poetry进行依赖管理。它通过读取.env文件获取维基媒体企业API的用户名和密码,并通过HTTP请求与API进行交互。该解决方案还包含测试用例,用于验证其功能的正确性。开发者可以使用poetry run pre-commit install命令安装pre-commit hooks,以确保代码质量。该解决方案的代码结构清晰,易于理解和维护。